图像处理与人工智能

自组织神经网络(self-organizing neural network)是一类采用无教师学习方式的神经网络模型,它无须期望输出,只是根据数据样本进行学习,并调整自身的权重以达到训练的目的。自组织神经网络的学习规则大都采用竞争型学习规则,但也有不同结构,有一维输出层的、二维输出层的、带有层反馈的等。

1. 自组织竞争网络:

竞争型神经网络的基本思想是网络竞争层的各神经元通过竞争来获取对输入模式的响应机会,最后仅有一个神经元成为竞争胜利者,并将与获胜神经元有关的各连接权值向着更有利于其竞争的方向调整。

竞争型网络可分为输入层和竞争层。假定输入层由N个神经元组成,竞争层有M个神经元,网络连接权值wij,i=1,2,...,N,j=1,2,...,M,且满足约束条件:

在竞争层中,神经元之间竞争,最终只有一个或者几个神经元获胜,以适应当前的输入样本。竞争胜利的神经元就代表着当前输入样本的分类模式。

竞争型网络的输入样本为二值向量,各元素取值0或1.竞争层神经元j的状态可按下式计算:

其中,xi为输入样本向量的第1个元素。根据竞争机制,竞争层中具有最大加权值的神经元k赢得竞争胜利,输出为:

![]()

竞争后的权值按照下式进行修正,对于所有的i,有:

![]()

其中,α为学习参数,0<α<<1,一般取0.01~0.03;m为输入层中输出为1的神经元个数:

权值调整公式中的xi/m项表示当xi为1时,权值增加;而当xi为0时,权值减小。也就是说,当xi活跃时,对应的第i个权值就增加,否则就减小。由于所有权值的和为1,所以当第i个权值增加或减小时,对应的其他权值就可能减小或增加。此外,该公式还保证了权值的调整满足所有的权值调整量之和为0。

2. 自组织特征映射神经网络:

自组织特征映射网络也称为Kohonen网络,或SOM(Self-Organizing Feature Map)网络,它是由芬兰学者Teuvo Kohonen于1981年提出的。该网络是一个由全连接的神经元阵列组成的无教师自组织自学习网络。

SOM网络的一个典型特征就是可以在一维或二维的处理单元阵列上,形成输入信号的特征拓扑分布,因此SOM网络具有抽取输入信号模式特征的能力。SOM网络一般只包含有一维阵列和二维阵列,但也可以推广到多维处理单元阵列中去。最常用的是二维阵列。

1)网络结构:

SOM网络模型由4部分组成:

·处理单元阵列:用于接受事件输入,并且形成对这些信号的判别函数

·比较选择机制:用于比较判别函数,并选择一个具有最大函数输出值的处理单元

·局部互连作用:用于同时激励被选择的处理单元及其最邻近的处理单元

·自适应过程:用于修正被激励的处理单元的参数,以增加其对应于特定输入判别函数的输出值

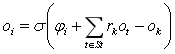

假定输入为X,输出神经元i与输入单元的连接权值为Wi,则输出神经元i的输出oi为:

![]()

网络实际具有响应的输出单元k,该神经元的确定是通过赢者通吃的竞争机制得到的,其输出为:

![]()

以上两式可修正为:

![]()

其中,wij为输出神经元i和输入神经元j之间的连接权值。xi为输入神经元i的输出。

σ(t)为非线性函数,即:

ε为一个很小的正数,rk为系数,它与权值及横向连接有关。Si为与处理单元i相关的处理单元集合,ok称为浮动阈值函数。

2)网络学习算法:

SOM网络的学习算法过程为:

⑴初始化。对N个输入神经元到输出神经元的连接权值赋予较小的权值,选取输出神经元j个邻接神经元的集合Sj,其中Sj(0)表示时刻t=0的神经元j的邻接神经元的集合,Sj(t)表示时刻t的邻接神经元的集合。区域Sj(t)随着时间的增长而不断缩小。

⑵提供新的输入模型X

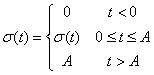

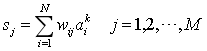

⑶计算欧式距离dj,即输入样本与每个输出神经元j之间的距离:

并计算出一个具有最小距离的神经元j*,即确定出某个单元k,使得对于任意的j,都有:

![]()

⑷给出一个周围的邻域Sk(t)

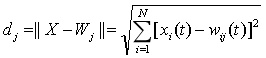

⑸按照下式修正输出神经元j*及其邻接神经元的权值:

![]()

其中,η为一个增益项,并随时间变化逐渐下降到零,一般取:

![]()

⑹计算输出:

![]()

其中,f()一般为0-1函数或其他非线性函数。

⑺提供新的学习样本来重复上述学习过程。

3. 自适应共振理论模型:

自适应共振理论简称ART(Adaptive Resonance Theory),是由S.Grossberg和A.Carpentent等人于1986年提出的。ART是以认知和行为模式为基础的一种无教师、矢量聚类和竞争学习的算法。在数学上,ART为非线性微分方程的形式;在网络上,ART是全反馈结构,且各层结点具有不同的性质。ART有ART-1、ART-2、ART-3三种类型。

1)ART-1型网络模型:

ART-1网络分为输入和输出两层,一般根据各层所有的功能特征称输入层为比较层,输出层为识别层。ART-1网络不仅具有从输入层到比较层的前向连接权,还有从输出层到输入层的反馈连接权。

假定网络输入层有N个神经元,输出层有M个神经元,二值输入模式和输出向量分别为:

![]()

![]()

其中,k=1,2,...,p,p为输入学习模式的数目,前向连接权和反馈连接权分别为wij和tij,j=1,2,...,M。

2)ART-1网络的学习和工作过程:

ART-1网络的学习及工作过程是通过反复地将输入学习模式由输入层向输出层自下而上地识别、由输出层向输入层自上而下地比较来实现的。当这种自下而上的识别和自上而下的比较达到共振,即输入向量可以正确反映输入学习模式的分类,且网络原有记忆没有受到不良影响时,网络对一个输入学习模式的记忆和分类就算完成。网络的学习和工作过程可以分为初始化阶段、识别阶段、比较阶段和探寻阶段。

ART-1网络的学习及工作过程可以归纳为如下过程:

⑴初始化:令tij(0)=1,wij(0)=1/(N+1),i=1,2,...,N,j=1,2,...,M。其中警戒参数0<ρ≤1。

⑵将输入模式Ak提供给网络输入层。

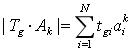

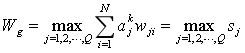

⑶计算输出层各个神经元的输入加权和:

⑷选择输入模式的最佳分类结果:

![]()

令神经元g的输出为1。

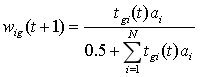

⑸计算以下三个公式,并进行判断:

![]()

如果最后一个公式成立,则转入⑺,否则转入步骤⑹。

⑹取消识别结果,将输出神经元g的输出值复位为0,并将这一神经元排除在下次识别的范围之外,返回步骤⑷.当所有已利用过的神经元都无法满足⑸中的最后的公式时,则选择一个新的神经元作为分类结果,并进入步骤⑺。

⑺接受识别结果,并按照下式调整连接权值:

![]()

其中,i=1,2,...,N。

⑻将步骤⑹中复位的所有神经元重新加入识别范围中,返回步骤⑵,对下一个模式进行识别。

无论网络学习还是回想,都使用以上规则,只不过在网络回想时,只对那些与未用过的输出神经元有关的的连接权值向量wij和tij才进行初始化,其他连接权值向量保持网络学习后的值不变。当输入模式是一个网络已记忆的学习模式时,不需要再进行网络权值的调整,这是因为当输入模式和网络记忆的学习模式完全相等,再按照权值调整公式进行调整时,网络连接权值不会发生任何变换。而当输入模式与网络记忆模式存在一定差异时,按照权值调整公式进行调整,将会影响网络原有模式的记忆效果。但是如果输入的是一个全新的模式,需要利用网络对其另加记忆时,则必须按照权值调整公式对网络连接权值进行调整。

ART-1网络仅以输出层中某个神经元代表分类结果,而不是像Hopfield网络那样把分类结果分散在各个神经元上来表示。所以,一旦输出层中某个输出神经元损坏,则会导致该神经元所代表类别的模式信息全部消失。

ART-2型网络与ART-1型的主要区别是:ART-2网络以模拟量作为输入模式,同时在算法上做了一些相应改进,并采用慢速学习方式,抗干扰能力增强。ART-3型网络是由多个ART-1型网络组成的复合阶层型网络。

4. 学习矢量量化神经网络:

学习矢量量化简称LVQ(Learning Vector Quantization),是一种在有教师状态下对竞争层进行训练的一种学习算法,是从Kohonen竞争算法演化而来的,在模式识别和优化领域有广泛应用。

1)LVQ网络的结构:

一个LVQ网络由三层神经元组成,输入层、隐含层和输出层,该网络在输入层与隐含层间为完全连接,而在隐含层与输出层间为部分连接,每个输出神经元与隐含层神经元的不同组相连接。隐含层与输出层神经元之间的权值固定为1,隐含神经元和输出神经元都具有二进制输出值。输入层和隐含层神经元之间的连接权值建立参考矢量的分量,在网络训练过程中,输入层与隐含层的连接权值被修改。

当某个输入模式被送至网络时,参考矢量最接近输入模式的隐含神经元因获得激发而赢得竞争,因而允许它产生一个1,而其他隐含神经元都被迫产生0;与包含获胜神经元的隐含神经元组相连接的输出神经元也发出1,而其他输出神经元均发出0。产生1的输出神经元给出输入模式的类,每个输出神经元被表示为不同的类。

2)LVQ网络的学习规则:

假定网络输入层的输入向量为X,M为输入层神经元的数目:

![]()

输入层和竞争层之间的连接权值矩阵为:

![]()

![]()

其中,i=1,2,...,p,j=1,2,...,M,wij表示输入层第i个神经元和第j个神经元之间的连接权值,p为竞争层神经元的数目,竞争层的输出向量为:

![]()

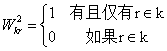

竞争层与输出神经元之间的连接权值矩阵为:

![]()

![]()

其中,k=1,2,...,N,r=1,2,...,p,wkr表示竞争层第k个神经元与输出层第r个神经元之间的连接权值,N为输出层神经元的数目。竞争层的每个神经元通过学习原型向量,并对输入空间进行分类。将竞争层学习得到的类称为子类,将输出层学习得到的类称为目标类。

LVQ神经网络的学习规则结合了竞争学习和有教师学习的规则,即需要一组正确网络行为的例子来训练该网络。假定有以下的训练模式:

![]()

其中,每个目标输出向量tj,j=1,2,...,Q,有且有一个分量为1,其他分量全都为0。为了使得学习过程可以进行下去,通常把第1层的每个神经元指定给一个输出神经元,这样就可以定义矩阵W2。W2的列表示子类,行表示类,W2的每一列仅有一个1出现的行,表明这个子类输入该行表示的类,即:

W2一旦定义好就不再改变。神经网络的学习是通过改进了的Kohonen规则使W1改变来进行的,即在每次迭代过程中,将一个输入向量X提供给网络,并且通过竞争层计算每个原型向量与X之间的距离,与X的距离最近的神经元i*获得竞争胜利,输出V的第i*个元素值设定为1,通过下式可计算得到输出向量Y的值:

![]()

显而易见,Y中的每一个分量也只有一个非零元素。假定其序号为k*,表明X是指定给k*类的。

对分类结果进行分析。如果分类正确,即:

![]()

则获胜的隐含神经元将沿着X的方向移动,按照下式修正竞争层权值向量:

![]()

如果分类不正确,即:

![]()

表示错误的隐含层神经元竞争获胜,则移动该神经元的权值远离X,修改竞争层权值向量:

![]()

其中,比例系数η位于区间(0,1)之间,在调整权值矩阵过程中反映调整速率。经过这样的处理后,每个神经元移向那些落入形成子类的类中的向量,而远离那些落入其他类中的向量。

3)神经网络在模式识别中的应用:

神经网络通过寻找输入/输出数据之间的关系,来实现特征提取和统计分类等模式识别任务,经过几十年的发展,神经网络已经奠定了在模式识别领域中不可或缺的位置。

在模式识别的应用中,单层感知器是能一致逼近线性连续函数空间最简单的神经网络,但有其固有的局限性,即对非线性样本空间不可分。BP网络是一种应用最为普遍的网络,其缺点在于采用了基于梯度下降的非线性优化策略,有可能陷入局部最小问题,不能保证求出全局最小值。其他一些优化策略,如遗传算法、模拟退火算法等,虽然可以求得全局最小,但是计算量很大,会出现效率问题。

可以使用LVQ网络来实现模式识别,优点是不需要将输入向量进行归一化、正交化,只需要直接计算输入向量与竞争层之间的距离,从而实现模式识别,简单易行。

5. 对向传播网络:

对向传播网络简称CPN(Counter Propagation),是美国计算机专家Robert Hecht-Nielsin于1987年提出的,是将Kohonen特征映射网络与Grossberg基本竞争型网站相结合,发挥各自特长的一种新型特征映射网络,广泛应用于模式分类、函数近似、统计分析和数据压缩等领域。

1)网络结构:

CPN网络分为输入层、竞争层和输出层,输入层与竞争层构成SOM网络,竞争层与输出层构成基本竞争型网络。从整体上看,网络属于有教师型的网络,而由输入层和竞争层构成的SOM网络又是一种典型的无教师型神经网络。因此,这种网络既汲取了无教师型网络分类灵活、算法简练的优点,又采纳了有教师型网络分类精细、准确的长度,使两种不同类型的网络有机地结合起来。

CPN的基本思想是,由输入层至输出层,网络按照BOM学习规则产生竞争层的获胜神经元,并按这一规则调整相应的输入层至竞争层的连接权;由竞争层都输出层,网络按照基本竞争型网络学习规则,得到各输出神经元的实际输出值,并按照有教师型的误差校正方法,修正由竞争层到输出层的连接权。经过这样的反复学习,可以将任意的输入模式映射为输出模式。

处于网络中间位置的竞争层获胜神经元及与其相关的连接权向量,既反映了输入模式的统计特性,又反映了输出模式的统计特性。可以认为,输入、输出模式通过竞争层实现了相互映射,即网络具有双向记忆的功能。如果输入/输出采用相同的模式对网络进行训练,则由输入模式至竞争层的映射可以认为是对输入模式的压缩;而由竞争层至输出层的映射可以认为是对输入模式的复原。利用这一特性,可以有效地解决图像处理及通信中的数据压缩及复原问题,并可得到较高的压缩比。

2)网络学习及工作规则:

假定输入层有N个神经元,p个连续值的输入模式为:

![]()

竞争层有Q个神经元,对应的二值输出向量为:

![]()

输出层有M个神经元,其连续值的输出向量和目标输出向量为:

![]()

![]()

以上k=1,2,...,p。

由输入层至竞争层的连接权值向量为:

![]()

由竞争层到输出层的连接权值向量为:

![]()

网络学习和工作规则为:

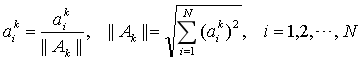

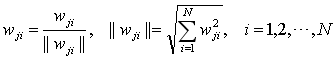

⑴初始化,将连接权向量Wj和Vl赋予区间[0,1]内的随机值,将所有的输入模式Ak进行归一化处理:

⑵将第k个输入模式Ak提供给网络的输入层。

⑶将连接权值向量Wj按照下式进行归一化处理:

⑷求竞争层中每个神经元的加权输入和:

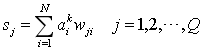

⑸求连接权向量Wj中与Ak距离最近的向量Wg:

将神经元g的输出设定为1,其余竞争层神经元的输出设定为0:

![]()

⑹将连接权向量Wg按照下式进行修正:

![]()

其中,0<ɑ<1为学习率。

⑺将连接权向量Wg重新归一化,归一化算法同上。

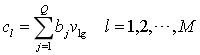

⑻按照下式修正竞争层到输出层的连接权向量Vl:

![]()

由此可见,只需要调整竞争层获胜神经元g到输出层神经元的连接权向量Vg即可,其他连接权向量保持不变。

⑼求输出层各神经元的加权输入,并将其作为输出神经元的实际输出值:

同理,可将其简化为:

![]()

⑽返回步骤⑵,直到将p个输入模式全部提供给网络。

⑾令t=t+1,将输入模式Ak重新提供给网络学习,直到t=T。其中T为预先设定的学习总次数,一般取500<T<10000。