编程语言

C#编程语言基础

C#面向对象与多线程

C#数据及文件操作

JavaScript基础

JavaScript的数据类型和变量

JavaScript的运算符和表达式

JavaScript的基本流程控制

JavaScript的函数

JavaScript对象编程

JavaScript内置对象和方法

JavaScript的浏览器对象和方法

JavaScript访问HTML DOM对象

JavaScript事件驱动编程

JavaScript与CSS样式表

Ajax与PHP

ECMAScript6的新特性

Vue.js前端开发

PHP的常量与变量

PHP的数据类型与转换

PHP的运算符和优先规则

PHP程序的流程控制语句

PHP的数组操作及函数

PHP的字符串处理与函数

PHP自定义函数

PHP的常用系统函数

PHP的图像处理函数

PHP类编程

PHP的DataTime类

PHP处理XML和JSON

PHP的正则表达式

PHP文件和目录处理

PHP表单处理

PHP处理Cookie和Session

PHP文件上传和下载

PHP加密技术

PHP的Socket编程

PHP国际化编码

MySQL数据库基础

MySQL数据库函数

MySQL数据库账户管理

MySQL数据库基本操作

MySQL数据查询

MySQL存储过程和存储函数

MySQL事务处理和触发器

PHP操作MySQL数据库

数据库抽象层PDO

Smarty模板

ThinkPHP框架

Python语言基础

Python语言结构与控制

Python的函数和模块

Python的复合数据类型

Python面向对象编程

Python的文件操作

Python的异常处理

Python的绘图模块

Python的NumPy模块

Python的SciPy模块

Python的SymPy模块

Python的数据处理

Python操作数据库

Python网络编程

Python图像处理

Python机器学习

TensorFlow深度学习

Tensorflow常用函数

TensorFlow用于卷积网络

生成对抗网络GAN

- TensorFow基础:

- TensorFlow的Hello:

- TensorFlow中的图:

- Session:

- 常量与变量:

- TensorFlow中的tf.placeholder:

- Tensor对象:

- Operation对象:

- TensorFlow流程控制:

- TensorFlow位运算:

- TensorFlow字符串:

- 高维Tensor对象的工具函数:

- 前馈卷积神经网络:

- 常见卷积神经网络:

- TensorFlow数据存取:

- TensorFlow数据预处理:

- TensorFlow模型训练:

- TensorBoard可视化工具:

- 移植TensorFlow模型到Android端:

一、TensorFlow基础:

TensorFlow是由Google Brain团队开发的一个开源的深度学习框架,为机器学习和深度学习提供了强大的支撑。TensorFlow结构灵活,用户可以轻松地将计算任务分配给CPU、GPU、TPU及服务器集群等。 TensorFlow采用符号式编程,一般先定义各种变量,然后建立一个数据流图,在数据流图中规定各个变量之间的计算关系,最后需要对数据流图进行编译。运行时需要将运算数据输入,才能在整个模型中形成数据流,从而形成输出值。

1. TensorFlow的Hello:

示例代码:

import tensorflow as tf # 将TensorFlow库引入

txt_tf=tf.constant('hello world!',ftype=tf.string,name='input') # 字符串以常量方式存入

with tf.Session() as sess: # 创建Session对象以管理TensorFlow中的图

txt=sess.run(txt_tf) # 启动图并将图中节点数据从图中引出成为Python对象

print(tx.decode()) # 将取出的Python对象打印出来

TensorFlow框架中也有int、float、string等数据类型,但是不能将Python中的数据类型与TensorFlow中的数据类型运算,只能先将Python中的数据转换为TensorFlow中的数据类型,由TensorFlow计算出结果,再从TensorFlow图中取出来。下面是矩阵运算示例:

import tensorflow as tf

A=[[1,2,3],[4,5,6]]

B=[[1,1],[1,1],[1,1]]

A_tf=tf.constant(A,dtype=tf.float32,name="A")

B_tf=tf.constant(B,dtype=tf.float32,name="B")

C_tf=tf.matmul(A_tf,B_tf)

with tf.Session() as sess:

C=sess.run(C_tf)

print(C)

2. TensorFlow中的图:

在TensorFlow中,会定义默认图,用户可以显式定义图,并将定义图作为默认图。

TensorFlow的图包含tf.Operation对象集合,一个tf.Operation对象表示一个计算单元,如加减乘除。TensorFlow中的图还包含tf.Tensor对象,表示参与运算的数据,这些数据在tf.Operation节点中参与运算,并在图的各个路经传递。

图中还可以包含任意多个集合,比如TensorFlow框架中创建了一个名为tf.GraphKeys.GLOBAL _VARIABLES的集合,所有变量对象(tf.Variable)在创建时都会放入到对应图的tf.GraphKeys. GLOBAL_VARIABLES的集合中。用户也可以创建自定义名城的集合,将需要共享的Tensor对象放入到自定义集合中,这样可以在代码的任意地方将共享的Tensor对象取出来。

TensorFlow框架区分不同的图是为了方便模块化管理,实际项目中往往一个图就够用了,可以通过函数tf.get

import tensorflow as tf

不同图中的数据和计算节点相互引用时会出现错误。在构建图时,各个数据对象和计算节点对象必须在当前图中,不同图之间的资源是不能交叉引用的。

A=[[1,2,3],[4,5,6]]

B=[[1,1],[1,1],[1,1]]

my_graph=tf.Graph()

with my_graph.as_default():

A_tf=tf.constant(A,dtype=tf.float32,name="A")

B_tf=tf.constant(B,dtype=tf.float32,name="B")

C_tf=tf.matmul(A_tf,B_tf)

print('C_tf.graph is my_graph:',C_tf.graph is my_graph)

with tf.Session(graph=my_graph) as sess:

C=sess.run(C_tf)

print(C)

TensorFlow主要使用静态图机制,顺序执行的TensorFlow框架的计算函数其实只是在构造图,计算并不会马上执行,只有调用了tf.Session对象的run函数时才启动图,图中的各个计算节点和数据按图执行。

使用静态图,当图构建完成时网络就已经确定,图结构不会再发生变化,这样底层库能将运算优化。但静态图也有缺点,定义网络模型要等图构建完成才能执行,给调试带来不便。目前,一些项目和模块也可以使用动态图。

3. Session:

TensorFlow的Session对象是一个上下文环境,Session对象管理着图中的资源对象、队列及文件读写等。在Session环境中可以取出关联的图中的数据对象,也可以执行关联图中指定的计算节点。

1)将Session对象关联Graph对象:

每个Session对象只能关联一个图,并且只能取这个图中的数据对象和执行这个图中的计算节点对象。如果程序中有多个图,则需要多个Session对象与之关联。将Session对象关联Graph对象后,可以在创建Session时,将Graph对象传入Session对象的构造函数,示例:

my_graph=tf.Graph()

sess=tf.Session(graph=my_graph)

如果创建Session对象时,没有在构造函数中传入Graph对象,则会使用默认的图关联到创建的Session对象中。Session对象只能对其关联图中的资源对象进行读写和运行。

不同的图由不同的Session对象关联管理,Session对象管理着很多资源对象。因此当不再使用Session对象时,需要调用Session对象的close()函数将其关闭。如果使用with tf.Session() as sess的方式创建和使用Session对象,则不需要显式调用close()函数。

2)Session参数配置:

Session对象掌管着图资源和硬件资源的使用和分配,用户可以通过向Session对象传递配置参数来管理硬件资源的分配。在Session的构造函数中,参数config用于将用户对网络训练时的一些参数进行配置,传入的是tf.ConfigProto对象、示例:

tf_config=tf.ConfigProto()

with if.Session(config==tf_config) as sess:

pass

接下来列举一些常用的参数设置,代码:

import tensorflow as tf

tf_config=tf.ComfigProto()

# GPU设置

tf_config.gpu_option.allow_growth=True # 根据实际代码运行情况动态占用GPU空间

tf_config.gpu_option.per_process_gpu_memory_fraction=0.9 # 设显存占用比例

tf_config.log_device_placement=True # 设定是否打印当前GPU、CPU的分配情况

tf_config.allow_soft_placement=True # 设定是否允许自动分配GPU和CPU

with if.Session(config==tf_config) as sess:

pass

默认情况下,为了得到更多的缓存空间,降低显存复制数据带来的耗时瓶颈,TensorFlow会一次性占满所有的显存空间。当有多块CPU卡时,即使其他GPU没参与训练,也会被占满。

因此,如果使用单机多卡训练多个网络模型时,很有必要将gpu_option.allow_growth设为True。需要注意,一旦TensorFlow得到显存的某块空间的使用权,就不会将已占用显存空间释放,这时为了避免出现更多显存空间碎片。

当gpu_option.allow_growth设为True时,刚开始只占用很少的显存空间,随着构建图过程中占用更多的实际空间,会逐步申请更多的显存空间,直到满足训练需要的大学为止。

可以为TensorFlow指定GPU占用比例,也可以在代码中指定每个代码块在哪块GPU卡中执行,也即一机多卡时所有卡对TensorFlow都“可见”。用户可以为TensorFlow训练进程指定可见的GPU,这样就可以让不同的训练进程只“看到”指定的GPU,其他GPU卡则“不可见”。设置方法:

os.environ['CUDA_VISIBLE_DEVICES']='0,1' # 将第0块GPU和第1块GPU设置为可见

os.environ['CUDA_VISIBLE_DEVICES']='0' # 只将第0块GPU设置为可见

也可以在训练命令时,加入指定的可见GPU的ID。比如代码:

CUDA_VISIBLE_DEVICES=0,1 python train.py

上述代码为train.py训练文件指定第0块GPU和第1块GPU可见。

4. 常量与变量:

1)TensorFlow中的常量:

常量一旦初始化后,就不能修改其值。TensorFlow中常量定义使用tf.constant,其函数原型:

tf.constant(

value,

dtype=None,

shape=None,

name='Const',

verify_shape=False

)

tf.constant中各个参数的类型及含义:

| 参数 | 类型 | 含义 |

|---|---|---|

| value | list或常数 | 常数的初始值,可以传入list对象或常数 |

| dtype | tf.Dtype | 常见有tf.string、tf.int16、tf.int32、tf.int64、tf.float16、tf.float32、tf.float64、tf.int8、tf.uint8、tf.bool等 |

| shape | list | 如果是一个数,则shape=[];如果是长度为n的数组,则shape=[n];如果是n行m列矩阵,则shape=[n,m];依次类推。 |

| name | string | 当前常量的名称 |

| verify_shape | bool | 是否对shape验证,验证实际维度与设置是否一致 |

import tensorflow as tf

input=[[1,2,3],[2,3,4]]

input_tf=tf.constanr(input)

#打印查看常量的shape

print(input_tf.get_shape().as_list())

print(input_tf.dtype)定义input_tf常量时,只传入了常量值,其他使用默认值,dtype根据数据类型自动判断为tf.int32,shape根据维度自动推导shape=[2,3]。默认不对shape验证。输出为:

[2, 3]

<dtype: 'int32'>如果常量类型为float32,shape设置为[2,3],代码为:

input_tf=tf.constanr(input, dtype=tf.float32, shape=[3,2])

with tf.Session() as sess:

print("input_tf value:\n",sess.run(input_tf))输出:

input_tf value:

[[1. 2.]

[3. 2.]

[3. 4.]]可见,自定义shape后,相当于对常量做了reshape操作。如果设置的shape的某个维度超过对应的实际shape维度,则会按照最后一个值做扩充。例如shape=[5,2],输出:

[[1. 2.]

[3. 2.]

[3. 4.]

[4. 4.]

[4, 4.]]2)TensorFlow中的变量:

变量是可以随时修改值的对象。

①通过tf.Variable对象创建变量:

TensorFlow中,变量可以通过创建tf.Variable对象或者调用tf.get_variable函数来创建。其中,tf.Variable对象的构造函数为:

_init_(

initial_value=None,

trainable=True,

collections=None,

validate_shape=True,

caching_device=None,

name=None,

variable_def=None,

dtype=None,

expected_shape=None,

import_scope=None,

constraint=None

)tf.Variable对象的构造函数中的参数比较多,但常用的参数并不多。需要关注的有:

· initial_value:变量初始化值,可以为TensorFlow对象,也可以是可转换为Tensor对象的Python对象

· trainable:bool类型,指定当前变量是否可训练,默认True。如为True,在训练模型反向传播时会自动更新,并且会将此变量加入集合tf.GraphKeys.TRAINABLE_VARIABLES中。

· collections:list类型,其中的对象为集合的key值。当此变量加入指定集合中,默认会加入tf

· name:字符串类型,为此变量指定名称。

· dtype:tf.Dtype类型,指定此变量的数据类型。

示例:

import tensorflow as tf

input=[[1,2,3],[2,3,4]]

input_tf=tf.Variable(input,dtype=tf.float32,name="input")

print("input_tf shape:",input_tf.get_shape().as_list())

print("input_tf dtype:",input_tf.dtype)

with tf.Session() as sess:

sess.run(tf.global_variables_inializer())

print("input_tf value:\n",sess.run(input_rf))输出:

input_tf shape: [2,3]

input_tf dtype:

input_tf value:

[[1. 2. 3.]

[2. 3. 4.]]在包含变量的图创建完成后,需要在执行计算之前为变量执行赋值操作,即执行sess.run

②通过tf.get_variable函数创建变量:

变量创建的另一种方法是使用tf.get_variable函数,与tf.Variable对象创建变量的区别在于:如果当前命名空间没有指定名称的变量,tf

_init_(

name,

shape=None,

dtype=None,

initializer=None,

regularizer=None,

trainable=True,

collections=None,

caching_device=None,

partitioner=None,

validate_shape=True,

use_resource=None,

custom_getter=None,

constraint=None

)函数tf.get_variable同样有很多参数,实际用到的不多。

· name:创建新的变量或者已存在的变量的名称。

· shape:创建新的变量或者已存在的变量的shape。

· dtype:创建新的变量或者已存在的变量的数据类型。

· initializer:如果是创建新的变量,则使用的初始化方法。

· trainable:bool类型,默认True。如果是True,训练时会在反向传播时自动更新,并且会加入图的tf.GraphKeys.TRAINABLE_VARIABLES集合中。

· collections:list类型,其中的对象为集合的key值。当此变量加入指定集合中,默认会加入tf

示例代码:

import tensorflow as tf

input=[[1,2,3],[2,3,4]]

#创建变量初始化器

initializer=tf.constant_initializer(input)

#创建变量

input_tf=tf.get_variable(name='input',shape=[2,3],initializer=initializer)

print("input_tf shape:",input_tf.get_shape().as_list())

print("input_tf dtype:",input_tf.dtype)

with tf.Session() as sess:

sess.run(tf.global_variables_inializer())

print("input_tf value:\n",sess.run(input_rf))输出与前面使用tf.Variable创建的一样。

注意,使用tf.get_variable创建变量时,如果是创建新变量,需要指定shape参数,否则会抛出错误。

③使用tf.Variable与tf.get_variable创建变量的区别:

在相同的命名空间,使用tf.Variable定义多个相同名称的变量,会自动创建新的变量,并且新的变量名称以“_1”、“_2”递增的方式作为后缀。创建的新变量与原来的变量指向的并不是同一个地址空间的变量。

④变量初始化方法:

tf.Variable是通过直接传入初始值的方式来指定初始化的值;而tf.get_variable则需要指定初始化器来实现初始化值。常用的初始化方法:

· tf_constant_initializer:按指定的常数来初始化变量,需要传入指定的常数。

· tf.ones_initializer:将变量中所有元素的初始值设置为1。

· tf.orthogonal_initializer:如果变量维度N=2,则以正交矩阵的方式初始化变量;如果维度N>2,则先reshape到[shape[0]xshape[1]x...xshape[N-1]xshape[N]],按正交矩阵方式初始化,然后再reshape回到[shape[1],shape[1],...,shape[N]]。

· tf.random_normal_initializer:按照随机正态分布的方式初始化变量。

· tf.random_uniform_initializer:按照随机均值分布的方式初始化变量。

· tf.truncated_normal_initializer:以截断正态分布的方式初始化变量。

· tf.zeros_initializer:将变量中所有元素的初始值设置为0。

· tf.contrib.layers.xavier_initializer:按照xavier算法初始化设置,在卷积核的初始化中常用到这种初始化方法。

⑤变量修改值:

变量值可以随时修改。在TensorFlow中,可以使用变量的assign函数为变量赋值。示例:

import tensorflow as tf

input=[[1,2,3],[2,3,4]]

input_tf=tf.Variable(input,dtype=tf.float32,name="input")

#将变量中每个值加1

add_one_tf=input_tf+1

#将计算结果赋值给input_tf

assign_op=input_tf.assign(add_one_tf)

with tf.Session() as sess:

sess.run(tf.globe_variables_initializer())

#由于赋值计算也是图中一个节点,需要显式指定执行赋值操作才能生效

_,input_v=sess.run([assign_op,input_tf])

print(input_v)赋值也是一个计算节点,赋值计算不在执行的路经中,那么需要显式地在Session对象的eun函数中执行,否则赋值操作不会生效。

5. TensorFlow中的tf.placeholder:

TensorFlow中有一类特殊节点,既可以看成常量也可以看成变量,就是tf.placeholder。tf.placeholder其实是一个占位符,它提前在图中占位,但是不需要给它初始化值。将数据填入到占位符后,其值在图中就不能再修改,但是在图之外又可以不断传入不同的值。在图运行时,可以动态设置tf.placeholder的值。

比如,在训练时要不断向图中传入不同的数据,这时可以选择tf.placeholder提前占位,然后在训练时不断将tf

tf.placeholder(

ftype,

shape=None,

name=None

)

下面是一个矩阵乘法的示例:

import tensorflow as tf

B=[[1,1],[1,1]],[1,1]]

A_tf=tf.placeholder(dtype=tf.float32,shape=[2,3],name='A')

B_tf=tf.constanr(B,dtype=tf.float32,shape=[3,2],name='B')

C_tf=tf.matmul(A_tf,B_tf)

with tf.Session() as sess:

A1=[[1,2,3],[1,2,3]]

A2=[[4,5,6],[4,5,6]]

A_list=[A1,A2]

for A in A_list:

C=sess.run(C_tf,feed_dict={A_rf:A})

print('\n',C)

执行矩阵乘法时,将占位符A_rf的值通过feed_dict参数传入。feed_dict是一个字典对象,所有的占位符都可以通过这个参数传入。代码执行后输出:

[[6. 6.]

[6. 6.]]

[[15. 15.]

[15. 15.]]

注意,当执行的路经包含占位符时,那么所有被包含的占位符必须要传入具体值,即需要通过feed_dict把所有路经中包含的占位符的值传入。

6. Tensor对象:

TensorFlow中,tf.Tensor对象是数据对象的句柄。数据对象包括输入的常量和变量,以及计算节点的输出数据对象。所有Python语言中的常见的数据需要转为TensorFlow中的Tensor对象后,才能使用TensorFlow框架中的计算节点。

Tensor使用中文就是张量,零维度张量表示的是标量,一维张量表示的是向量,二维张量表示的是矩阵。在TensorFlow中,训练神经网络模型时,常见的Tensor维度为四维。常见四维Tensor的shape为[batch, height, width, channels],即一个Batch的输入图片数量,网络层输出特征图的高度、宽度及通道数。

TensorFlow中,Tensor对象可以存储任意维度的张量,图中参与运算的数据都是Tensor对象。Tensor对象往往是一个计算操作节点(Operation对象,简写op)的输出,输入其实也可以看成取数据op的输出。完成构图后,获取指定名称的Tensor对象,查找指定名称的Tensor对象的示例:

import tensorflow as tf

data=[[1,2],[3,4]]

#定义变量Tensor

A_tf=tf.Variable(data,name='A')

#定义常量Tensor

B_tf=tf.constant(data,name='B')

#根据Tensor的名称获取Tensor

A_tmp=tf.get_default_graph().get_tensor_by_name('A:0')

B_tmp=tf.get_default_graph().get_tensor_by_name('A:0')

#将查找得到的Tensor对象做矩阵乘法

C_tf=tf.matmul(A_tmp,B_tmp)

#打印Tensor对象

print('Tensor named "A:0": ',A_tmp)

print('Tensor named "B:0": ',B_tmp)

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

A_v,B_v,C_v=sess.run([A_tmp,B_tmp,C_tf])

print('\n Tensor named "A:0" value: \n',A_v)

print('\n Tensor named "B:0" value: \n',B_v)

print('\n Matmul output: \n',C_v)

1)Python对象转Tensor对象:

Python中的内置数据类型是不能直接放入TensorFlow框架中参与计算的,因为TensorFlow计算之前需要先构图,而只有Tensor对象和Operation对象才能参与构图。因此,需要一个接口函数,将Python中的对象转为TensorFlow中的Tensor对象。

在TensorFlow中,函数tf.convert_to_tensor用于将Python基本数据类型对象转为Tensor对象。tf.convert_to_tensor并不能将所有的Python对象转换成Tensor对象,只能转换指定数据类型的对象。内置的基本数据类型int、float、string、list及Numpy库的数组等都可以使用tf.convert_to_tensor函数转换,函数原型为:

tf.convert_to_tensor(

value,

dtype=None,

name=None,

preferred_dtype=None

)

其中参数:

· value:需要转为Tensor对象的数据。

· dtype:指定Tensor对象的数据类型,如果未指定则根据value值来判断。

· name:转成Tensor后的名称。

· preferred_dtype:返回的Tensor对象指定备选的数据类型。如果dtype为None,该参数才生效。

示例:

import tensorflow as tf

#定义python的字符串对象

str_py='hello world'

#将字符串对象转为Tensor对象

str_tf=tf.convert_to_tensor(str_py,dtype=tf.string)

print('str_tf=',str_tf)

with tf.Session() as sess:

#Tensor对象取出来的是字符串对应的字节对象

str_bytes=sess.run(str_tf)

str_v=str_bytes.decode()

print(str_v)

输出结果:

str_tf=Tensor("Const:0", shape=(), dtype=string)

hello world

下面示例为Python的list对象转为Tensor对象:

import tensorflow as tf

#定义python的list对象

list_py=[[1,2,3],[4,5,6]]

#将list对象转为Tensor对象,指定数据类型float32

list_float32_tf=tf.convert_to_tensor(list_py,dtype=tf.float32)

#将list对象转为Tensor对象,并自动推断数据类型

list_infer_tf=tf.convert_to_tensor(list_py)

print('list_float32_tf=',list_float32_tf)

print('list_infer_tf=',list_infer_tf)

with tf.Session() as sess:

#Tensor对象取出来的是字符串对应的字节对象

float32_list,infet_list=sess.run([list_float32_tf,list_infer_tf])

print('\n float32_list:\n',float32_list)

print('\n infer_list:\n',infer_list)

输出显示:

list_float32_tf=Tensor("Const:0", shape=(2,3), dtype=float32)

list_infer_tf=Tensor("Const_1:0", shape=(2,3), dtype=int32)

float32_list:

[[1. 2. 3.]

[4. 5. 6.]]

infer_list: [[1. 2. 3.]

[4. 5. 6.]]

2)Tensor对象转Python对象:

在TensorFlow中各个计算节点(Operation对象)只能对Tensor对象做运算,对TensorFlow图中的Tensor做运算只能用框架自带的计算节点运算。但实际项目中,可能需要对图中某个Tensor对象做一些运算处理并返回。这时,需要将Tensor对象转为Python对象,计算后转为Tensor对象返回。

在TensorFlow框架中,提供了函数tf.py_func实现自动将Tensor对象转为Python对象,并作为Python函数的形参传入,同时Python函数返回的结果又自动转为Tensor对象返回。也就是说,tf.py_func函数能执行指定的Python函数,并自动将Tensor对象转为Python对象,再将返回的Python对象转为Tensor对象。tf.py_func函数原型:

tf.py_func(

func,

inp,

Tout,

stateful=True,

name=None

)

各个参数的含义及类型:

· func:Python函数类型,指定要执行的函数

· inp:list类型,list里面存放的是Tensor对象,用于传入func函数作为形参

· Tout:list类型或单个对象,存放的是TensorFlow数据类型,用于描述func函数返回数据转为Tensor对象后的数据类型。

· stateful:bool类型,默认True。如果设置为True,则该函数被认为是与状态有关的。如果函数与状态无关,则相同的输入会产生相同的输出。

· name:当然Operation的名称。

下面以自定义两个Tensor对象做加法运算示例:

import tensorflow as tf

def my_add_func(A,B):

#查看传入参数的数据类型

print('type(A)=',type(A))

print('type(B)=',type(B))

C=A+B

return C

#定义Tensor对象

A_tf=tf.constant([[1,1],[1,1]],dtype=tf.int64)

B_tf=tf.constant([[2,2],[2,2]],dtype=tf.int64)

C_tf=tf.py_funct(my_add_func,[A_tf,B_tf],tf.int64)

with tf.Session() as sess:

C=sess.run(C_tf)

print(C)

输出结果:

type(A) = <class 'numpy.ndarray'>

type(B) = <class 'numpy.ndarray'>

[[3 3]

[3 3]]

3)SparseTensor对象:

在TensorFlow中,SparseTensor对象表示稀疏矩阵。SparseTensor对象通过3个稠密矩阵indices、values、dense

· indices:数据类型为int64的二维Tensor对象,shape为{N,ndime]。indices保存的是非零值的索引,即稀疏矩阵中除了indices保存的位置外,其他位置均为0。

· values:一维Tensor对象,其shape为[N],对应的是稀疏矩阵中indices索引位置中的值。

· dense_shape:数据类型为int64的一维Tensor对象,其维度[ndims],用于指定当前稀疏矩阵对应的shape。

生成稀疏矩阵的示例:

import tensorflow as tf

#定义Tensor对象

indices_tf=tf.constant([[0,0],[1,1]],dtype=tf.int64)

values_tf=tf.constant([1,2],dtype=tf.float32)

dense_shaoe_tf=tf.constant([3,3],dtype=tf.int64)

sparse_tf=tf.SparseTensor(indices=indices_tf,values=values_tf,dense_shape=dense_shape_tf)

dense_tf=tf.sparese_tense_to_dense(sparse_tf,default_value=0)

with tf.Session() as sess:

sparse,dense=sess.run([sparse_tf,dense_tf)

print('sparse:\n',sparse)

print('dense:\n',dense)

代码中使用tf.sparese_tense_to_dense()将稀疏矩阵转为稠密矩阵。输出结果:

parse:

SparseTensorValue(indices=array([[0,0],[1,1]],dtype=int64),values=array([1.,2.],

dtype=float32),dense_shape=array([3,3],ftype=int64))

dense:

[[1. 0. 0.]

[0. 2. 0.]

[0. 0. 0.]]

4)强制转换Tensor对象数据类型:

在TensorFlow中,函数tf.to_int32、tf.to_int64、tf.to_float、tf.to_double、tf.to_bfloat16、tf.to_complex64、tf.complex128等用于强制转换数据类型,如果无法转换为对应数据类型,则会抛出异常。示例:

complex64_tf=tf.to_complex64(data_tf)

7. Operation对象:

Operation对象也是图的重要组成部分,表示图中的一个节点。Operation对象有0个或0个以上的Tensor对象作为输入,并且有0个或0个以上的Tensor为输出。

1)Operation对象的创建:

当调用TensorFlow框架中的函数时,会在图中创建对应类型的Operation对象。示例:

import tensorflow as tf

A_tf=tf.constant([[1,1],[1,1]],dtype=tf.float32)

B_tf=tf.constant([[2,2],[2,2]],dtype=tf.float32)

C_tf=tf.matmul(A_tf,B_tf)

D_tf=C_tf+A_tf

graph=tf.get_default_graph()

ops=graph.get_operations()

print(ops)

代码输出结果:

[<tf.Operation 'Const' type=Const>,

<tf.Operation 'Const_1' type=Const>,

<tf.Operation 'MatMul' type=MatMul>,

<tf.Operation 'add' type=Add>]

可以看出,将Python的list转为Tensor常量的操作是类型Const的Operation对象,矩阵乘法和矩阵加法分别对应MatMul类型和Add类型的Operation对象。

2)获取并执行Operation对象:

在TensorFlow中,可以通过tf.Graph.get_operation_by_name来根据名称返回Operation对象,并且可以通过tf.get_default_session().run(op)来执行指定的Operation对象。当图中有变量时,需要执行sess

import tensorflow as tf

A_tf=tf.Variable([[1,1],[1,1]],dtype=tf.float32)

#为A_tf赋值

A_tf.assign(A_tf+1)

#获取当前图

graph=tf.get_default_graph()

#获取当前图中所有的Operation并打印

ops=graph.get_operations()

print(ops)

#找到初始化Operation

init_op=graph.get_operation_by_name('Variable/Assign)

with tf.Session() as sess:

#初始化操作

sess.run(init_op)

#取出变量值

print(sess.run(A_tf))

输出结果:

[<tf.Operation 'Variable/initial_value' type=Const>,

<tf.Operation 'Variable' type=VariableV2>,

<tf.Operation 'Variable/Assign' type=Assign>,

<tf.Operation 'Variable/read' type=Identity>,

<tf.Operation 'add/y' type=Const>,

<tf.Operation 'add' type=Add>,

<tf.Operation 'Assign' type=Assign>]

[[1. 1.]

[1. 1.]]

可以发现,代码中虽然A_tf的值加1并重新赋值给A_tf了,但这个操作并不在执行的路经中,因此还是显示的初始化值。需要手动执行这个赋值Operation对象,示例:

import tensorflow as tf

A_tf=tf.Variable([[1,1],[1,1]],dtype=tf.float32)

#为A_tf赋值

A_tf.assign(A_tf+1)

#获取当前图

graph=tf.get_default_graph()

#获取当前图中所有的Operation并打印

ops=graph.get_operations()

print(ops)

#找到初始化Operation

init_op=graph.get_operation_by_name('Variable/Assign)

add_op=graph.get_operation_by_name('Assign')

with tf.Session() as sess:

#初始化操作

sess.run(init_op)

#取出变量值

print(sess.run(A_tf))

#执行赋值操作

sess.run(add_op)

#取出变量赋值后的值

print(sess.run(A_tf))

代码执行后,前面显示一样,最后添加了显示:

[[2. 2.]

[2. 2.]]

8. TensorFlow流程控制:

TensorFlow中所有的计算必须在图中构建完成后才能执行,而Python的逻辑判断语句无法加入到静态图中,因此需要使用TensorFlow自带的逻辑判断语句函数,将流程控制语句加入静态图。

1)条件判断tf.cond与tf.where:

在TensorFlow中。函数tf.cond与tf.where都可以用于条件判断。其中tf.cond函数的原型:

tf.cond(

pred,

true_fn=None,

false_fn=None,

strict=False,

name=None,

fn1=None,

fn2=None

)

参数的含义及类型:

· pred:标量,用于决定是返回true_fn()的结果还是false_fn()的结果。

· true_fn:函数,当pred为true时执行该函数,并返回该函数执行的结果。

· false_fn:函数,当pred为false时执行该函数,并返回该函数执行的结果。

· strict:bool类型,用于设置是否启用strict模式。

· name:string类,作为tf.cond函数返回的Tensor对象名称的前缀。

· fn1:该参数已废除。

· fn2:该参数已废除。

函数true_fn和false_fn返回的都是Tensor对象列表,并且它们必须返回相同数据和类型的输出。示例:

import tensorflow as tf

A_tf=tf.Variable([[1,1],[2,2]],dtype=tf.float32)

B_tf=tf.Variable([[3,3],[4,4]],dtype=tf.float32)

a=tf.placeholder(shape=(),dtype=tf.int32)

b=tf.placeholder(shape=(),dtype=tf.int32)

result_tf=tf.cond(a

result_1=sess.run(result_rf,feed_dict={a:1,b:2})

result_2=sess.run(result_rf,feed_dict={a:2,b:1})

print('result_1:\n',result_1)

print('result_2:\n',result_2)

代码的逻辑比较简单,对Tensor对象a和b比较,如果a<b则返回A_tf和B_tf的相加结果,否则返回矩阵乘法结果。

tf.cond函数的pred必须为标量,也就是维度为0。tf.where允许条件语句为张量对象,函数原型:

tf.where(

condition,

x=None,

y=None,

name=None

)

参数含义及类型:

· condition:Tensor对象,其中该Tensor对象的数据类型为tf.bool类型。

· x:Tensor对象,x的第一个维度大小必须与condition大小相同。

· y:Tensor对象,y的shape必须与x的shape一致。

· name:当前Operation对象(tf.where)的名称。

函数tf.where返回的Tensor对象的数据来自x或y,每个坐标位置的值取x还是y对应的位置的元素由condition决定。如果x和y都为None,那么tf.where返回condition中为true的元素的坐标,该坐标存放在二维Tensor中。如果x和y都不是None,那么x和y必须有相同的shape。如果x和y都是标量,则condition必须是标量。

如果x和y为向量或者更高维度的张量,则condition必须是大小跟x的第一个维度相同的向量或者是跟x相同的shape。如果condition是向量且x和y是高维张量,那么tf.where会选择x或y中第一个维度中的数据进行复制。示例:

import tensorflow as tf

A_tf=tf.constant([[1,3,3],[5,2,4]],dtype=tf.float32)

B_tf=tf.constant([[3,2,1],[2,4,5]],dtype=tf.float32)

#情况1:x和y均为None

result_1=tf.where(A_tf

result_2=tf.where(A_tf

con_tf=tf.constant([True,False],dtype=tf.bool)

result_3=tf.where(con_tf

rs_1,rs_2,rs_3=sess.run([result_1,result_2,result_3])

print('rs_1:\n',rs_1)

print('rs_2:\n',rs_2)

print('rs_3:\n',rs_3)

代码中,情况1的含义是找出A_tf比B_tf小的元素坐标;情况2的含义是比较A_tf和B_tf,将较小值返回;情况3的含义是返回A_tf的第1行和B_tf的第2行组成新Tensor。输出结果:

rs_1:

[[0 0]

[1 1]

[1 2]]

rs_2:

[[1. 2. 1.]

[2. 2. 4.]]

rs_3:

[[1. 3. 3.]

[2. 4. 5.]]

2)TensorFlow比较判断:

TensorFlow中,比较运算符有tf.less、tf.less_equal、tf.equal、tf.not_equal、tf.greater、tf.greater_equal等,其函数原型及参数含义为:

· tf.less(x,y,name=None):x和y均为Tensor对象且x和y有相同的数据类型和shape。按对应坐标对x和y中的每个元素做比较,如果x中的元素小于y中对应的元素,则返回True,否则返回False。返回的Tensor对象与x和y的shape相同,但数据类型为tf.bool。

· tf.less_equal(x,y,name=None):x和y均为Tensor对象且x和y有相同的数据类型和shape。按对应坐标对x和y中的每个元素做比较,如果x中的元素小于等于y中对应的元素,则返回True,否则返回False。返回的Tensor对象与x和y的shape相同,但数据类型为tf.bool。

· tf.equal(x,y,name=None):x和y均为Tensor对象且x和y有相同的数据类型和shape。按对应坐标对x和y中的每个元素做比较,如果x中的元素等于y中对应的元素,则返回True,否则返回False。返回的Tensor对象与x和y的shape相同,但数据类型为tf.bool。

· tf.not_equal(x,y,name=None):x和y均为Tensor对象且x和y有相同的数据类型和shape。按对应坐标对x和y中的每个元素做比较,如果x中的元素不等于y中对应的元素,则返回True,否则返回False。返回的Tensor对象与x和y的shape相同,但数据类型为tf.bool。

· tf.greater(x,y,name=None):x和y均为Tensor对象且x和y有相同的数据类型和shape。按对应坐标对x和y中的每个元素做比较,如果x中的元素大于y中对应的元素,则返回True,否则返回False。返回的Tensor对象与x和y的shape相同,但数据类型为tf.bool。

· tf.greater_equal(x,y,name=None):x和y均为Tensor对象且x和y有相同的数据类型和shape。按对应坐标对x和y中的每个元素做比较,如果x中的元素大于等于y中对应的元素,则返回True,否则返回False。返回的Tensor对象与x和y的shape相同,但数据类型为tf.bool。

这些比较判断函数的功能类似,用法也基本一致,以tf.less函数为例介绍,示例:

import tensorflow as tf

A_tf=tf.constant([[1,3,3],[5,2,4]],dtype=tf.float32)

B_tf=tf.constant([[3,2,1],[2,4,5]],dtype=tf.float32)

A_less_B_tf=tf.less(A_tf,B_tf)

with tf,Session() as sess:

A_less_B=sess.run(A_less_B_tf)

print(A_less_B)

输出结果:

[[True False False]

[False True True]]

3)TensorFlow的逻辑运算:

TensorFlow中,逻辑运算函数有tf.logical_and、tf.logical_or、tf.logical_not、tf.logical_xor等。函数原型及其参数含义:

· tf.logical_and(x,y,name=None):x和y均为类型为tf.bool的Tensor对象,且x和y有相同的shape。对x和y中每个维度对应位置的元素做与运算,并将结果返回。

· tf.logical_or(x,y,name=None):x和y均为类型为tf.bool的Tensor对象,且x和y有相同的shape。对x和y中每个维度对应位置的元素做或运算,并将结果返回。

· tf.logical_not(x,y,name=None):x和y均为类型为tf.bool的Tensor对象,且x和y有相同的shape。对x和y中每个维度对应位置的元素做非运算,并将结果返回。

· tf.logical_xor(x,y,name=None):x和y均为类型为tf.bool的Tensor对象,且x和y有相同的shape。对x和y中每个维度对应位置的元素做异或运算,并将结果返回。

示例:

import tensorflow as tf

A_tf=tf.constant([[True,False,True],[False,True,True]],dtype=tf.bool)

B_tf=tf.constant([[False,True,False],[False,False,True]],dtype=tf.bool)

logical_and_tf=tf.logical_and(A_tf.B_tf)

with tf.Session() as sess:

logical_and=sess.run(logical_and_tf)

print('logical_and:\n',logical_and)

输出结果:

logical_and:

[[False False False]

[False False True]]

4)循环tf.while_loop:

函数tf.while_loop用于执行循环语句,与Python中的for循环作用相同。函数原型:

tf.while_loop(

cond,

body,

loop_vars,

shape_invariants=None,

parallel_iterations=10,

back_prop=True,

swap_memory=False,

name=None,

maximum_iterations=None

)

函数tf.while_loop的各个参数含义及类型:

· cond:函数类型,用于作为循环结束判断条件,返回tf.bool类型。

· body:函数类型,用于作为循环体,返回与loop_vars相同长度和数据类型的Tensor对象。

· loop_vars:可以取元组、list、Tensor及TensorArray等类型,定义传入cond函数和body函数的形参。

· shape_invariants:list类型,表示loop_vars的参数对应的固定shape。

· parallel_iterations:正整数类型,表示允许并行执行的最大迭代次数。

· back_prop:bool类型,表示是否允许当前循环参与反向传播计算。

· swap_memory:bool类型,表示是否启用GPU和CPU之间的内存复制。

· name:字符串类型,可选,用于定义该循环返回的Tensor对象的名称前缀。

· maximum_iterations:整数类型,可选,定义当前循环最大的循环次数。如果该参数定义,会将cond函数的结果和当前迭代次数与最大值比较的结果做与运算,以确保迭代次数不会超过maximum_iterations。

函数tf.while_loop要求循环中传入函数的形参的shape在每个迭代中是固定不便的。示例:

import tensorflow as tf

init_i=tf.constant(0) # 定义形参

def cond(i):

return tf.less(i,10)

def body(i):

return tf.add(i,1)

result_tf=tf.while_loop(cond,body,[init_i])

with tf.Session() as sess:

print('result:',sess.run(result_tf)

程序执行过程:初始传入cond和body函数的形参i的值为0,后面每次迭代时,传入cond和body函数的形参i均为上一次迭代中body函数的输出值。执行结果:

result: 10

有多个形参参与运算的示例:

import tensorflow as tf

init_i=tf.constant(0) # 定义形参

init_A=tf.constant([[1,1],[1,1]],tf.float32) # 定义形参

init_B=tf.constant([[2,2],[2,2]],tf.float32) # 定义形参

def cond(i,A,B):

return tf.less(i,2)

def body(i,A,B):

return tf.add(i,1),A+A,A+B

i_tf,A_tf,B_tf=tf.while_loop(cond,body,[init_i,init_A.init_B])

with tf.Session() as sess:

i,A,B=sess.run([i_tf,A_tf,B_tf])

print('i:',i)

print('A:',A)

print('B:',B)

在cond函数中指定了循环迭代次数为2;在body函数中定义每次循环迭代时要执行的函数,并把返回的值作为下一次迭代的输入。输出结果:

i: 2

A: [[4. 4.]

[4. 4.]]

B: [[5. 5.]

[5. 5.]]

9. TensorFlow位运算:

1)位与运算:

即对Tensor中的数据按二进制位做与运算。TensorFlow中,函数tf.bitwise.bitwise_and用于对两个Tensor对象做位与运算,函数原型:

tf.bitwise.bitwise_and(

x,

y,

name=None

)

函数各参数的含义及类型:

· x:Tensor对象,其数据类型只能为int8、int16、int32、int64、uint8、uint16、uint32、uint64中的一种。

· y:Tensor对象,其数据类型与x一致。

· name:字符串类型,当前位与运算的名称。

示例:

import tensorflow as tf

A_tf=tf.constant([[1,3],[5,7]],tf.uint8)

B_tf=tf.constant([[2,4],[6,8]],tf.uint8)

C_tf=tf.bitwise.bitwise_and(A_tf,B_tf)

with Session() as sess:

C=sess.run(C_tf)

print('C=',C)

输出结果:

C=[[0 0]

[4 0]]

2)位或运算:

即对Tensor中的数据按二进制位做或运算。TensorFlow中,函数tf.bitwise.bitwise_or用于对两个Tensor对象做位或运算,函数原型:

tf.bitwise.bitwise_or(

x,

y,

name=None

)

函数各参数的含义及类型:

· x:Tensor对象,其数据类型只能为int8、int16、int32、int64、uint8、uint16、uint32、uint64中的一种。

· y:Tensor对象,其数据类型与x一致。

· name:字符串类型,当前位或运算的名称。

3)位异或运算:

即对Tensor中的数据按二进制位做异或运算。TensorFlow中,函数tf.bitwise.bitwise_xor用于对两个Tensor对象做位异或运算,函数原型:

tf.bitwise.bitwise_xor(

x,

y,

name=None

)

函数各参数的含义及类型:

· x:Tensor对象,其数据类型只能为int8、int16、int32、int64、uint8、uint16、uint32、uint64中的一种。

· y:Tensor对象,其数据类型与x一致。

· name:字符串类型,当前位异或运算的名称。

4)位取反运算:

即对Tensor中的数据按二进制位做非运算。TensorFlow中,函数tf.bitwise.invert用于对两个Tensor对象做位或运算,函数原型:

tf.bitwise.invert(

x,

name=None

)

函数各参数的含义及类型:

· x:Tensor对象,其数据类型只能为int8、int16、int32、int64、uint8、uint16、uint32、uint64中的一种。

· name:字符串类型,当前位取反运算的名称。

10. TensorFlow字符串:

在训练网络模型读取训练集数据时,如果数据的标记格式比较复杂,则需要对标记字符串进行解析,需要对自定义格式的解析能力。

1)字符串的定义:

字符串的定义是在定义变量或常量时,通过指定参数dtype=tf.string的方式来定义字符串类型的Tensor对象。示例:

import tensorflow as tf

A_str_tf=tf.constant('Hello TensorFlow!',dtype=tf.string)

B_str_tf=tf.Variable('Hello TensorFlow!',dtype=tf.string)

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

print(sess.run(A_str_tf).decode())

print(sess.run(B_str_tf).decode())

2)字符串的转换:

将Number类型(包括int、float等数据类型)的Tensor转换为字符串的Tensor,使用函数tf.as_string;而函数tf.string_to_number用于将字符串类型的Tensor对象转换为指定数据类型的Tensor对象。

tf.as_string的函数原型:

tf.as_string(

input,

precision=-1,

scientific=False,

shortest=False.

width=-1,

fill=''.

name=None

)

函数tf.as_string各参数的含义及数据类型:

· input:Tensor对象,作为转换成tf.string数据类型的输入,其数据类型只能为int32、int64、complex64、float32、float64、bool、int8中的一种。

· precision:int类型,用于表示小数点后面的精度,只有大于-1时才有效。

· scientific:bool类型,用于设置是否使用科学计数法表示浮点数。

· shortest:bool类型,用于设置是否从科学计数法和标准浮点表示中取较短的表示方法。

· width:int类型,将小数点前面的数填充到指定宽度,当大于-1时才有效。

· fill:字符串类型,当参数大于-1时,在小数点前面填充的字符串,该字符串参数的长度不能超过1。

· name:字符串类型,设置当前Operation对象的名称。

以tf.float32数据类型转换为tf.string数据类型为例:

import tensorflow as tf

A_float_tf=tf.constant([1,2,3,4,5,6],dtype=tf.float32)

A_str_tf=tf.as_string(A_float_tf)

with tf.Session() as sess:

bytes_v=sess.run(A_str_tf)

A_str=[v.decode() for v in bytes_v]

print(A_str)

输出结果:

['1.000000','2.000000','3.000000','4.000000','5.000000','6.000000']

将tf.string类型转换为Number类型的函数tf.string_to_number的原型:

tf.string_to_number(

string_tensor,

out_type=tf.float32,

name=None

)

函数原型的各参数含义及数据类型:

· string_tensor:Tensor对象,数据类型为tf.string。

· out_type:tf.Dtype对象,用于设置转换后输出的Tensor数据类型,只能取tf.float32、tf.float64、tf.inr32、tf.int64中的一种,默认tf.float32。

· name:字符串类型,设置当前Operation对象的名称。

以tf.string数据类型转换为tf.float32数据类型为例:

import tensorflow as tf

A_str_tf=tf.constant(['1.0','2.5','3.1','4.0','5.9','6.2'],dtype=tf.string)

A_float_tf=tf.string_to_number(A_str_tf,out_type=tf.float32)

with tf.Session() as sess:

print(sess.run(A_float_tf))

输出结果:

[1. 2.5 3.1 4. 5.9 6.2]

将tf.string转为Number类型时,必须保证tf.dtring存储的数据能准确转为指定Number数据类型。

3)字符串拆分:

在TensorFlow中,函数tf.string_split用于根据指定的分隔符将字符串进行拆分。函数原型:

tf.string_split(

source,

delimiter=' ',

skip_empty=True

)

各个参数的含义及数据类型:

· source:一维Tensor对象,其数据类型为tf.string,作为分割的输入。

· delimiter:标量Tensor对象,表示分割字符,其字符串长度只能为0或1。

· skip_empty:bool类型,表示是否跳过空的字符串。

函数tf.string_split返回的是稀疏矩阵SparseTensor对象,示例:

import tensorflow as tf

A_str_tf=tf.constant(['1,2,3,4,5'],dtype=tf.string)

A_arr_tf=ttf.string_split(A_str_tf,delimiter=',')

with tf.Session() as sess:

A_arr=sess.run(A_arr_tf)

print('indices :\n',A_arr.indices)

print('ivalues :\n',[v.decode() for v in A_arr.values])

print('dense shape :\n',A_arr.dense_shape)

输出:

indices :

[[0 0]

[0 1]

[0 2]

[0 3]

[0 4]]

values : ['1','2','3','4','5']

dense shape : [1 5]

注意,函数tf.string_split的第1各参数必须是一维的且数据类型为tf.string的Tensor对象。

4)字符串拼接:

在TensorFlow中,函数tf.string_join用于将list中数据类型为tf.string的多个Tensor对象拼接成一个数据类型为tf.string的Tensor对象、函数原型:

tf.string_join(

inputs,

separator=' ',

name=None

)

各个参数的含义及数据类型:

· inputs:list类型,list中存放的是数据类型为tf.string的Tensor。

· separator:字符串类型,表示各个字符串中的连接符。

· name:字符串类型,设置当前Operation对象的名称。

示例:

import tensorflow as tf

A_str_tf=tf.constant('hello',dtype=tf.string)

B_str_tf=tf.constant('tensor',dtype=tf.string)

C_str_tf=tf.constant('flow',dtype=tf.string)

ABC_str_tf=ttf.string_join([A_str_tf,B_str_tf,C_str_tf],separator='_&_')

with tf.Session() as sess:

ABC_str=sess.run(ABC_str_tf)

print(ABC_str.decode())

输出结果:

hello_&_tensor_&_flow

如果Tensor对象的维度是多维的,则每个维度对应执行拼接,示例:

import tensorflow as tf

A_str_tf=tf.constant([['hello'],['1']],dtype=tf.string)

B_str_tf=tf.constant([['tensor'],['2']],dtype=tf.string)

C_str_tf=tf.constant([['flow'],['3']],dtype=tf.string)

ABC_str_tf=ttf.string_join([A_str_tf,B_str_tf,C_str_tf],separator='_&_')

with tf.Session() as sess:

ABC_str=sess.run(ABC_str_tf)

print(ABC_str.decode())

输出结果:

[[b'hello_&_tensor_&_flow']

[b'1_&_2_&_3']]

注意,TensorFlow中,输出类型为tf.string的Tensor对象通过tf.Session().run()函数取出后是字节数组类型。

二、高维Tensor对象的工具函数:

数据的维度上升到四维甚至更高维度时,往往比较抽象。高维Tensor对象的运算是在低维Tensor运算基础上的推广。

1. 重定义shape:

TensorFlow中,单张图片一般采用shape为[height,width,channels],即第1个维度表示图片的高度,第2个维度表示图片的宽度,第3个维度表示图片的通道数。如shape=[256,128,3],即表示图片宽度为256、宽为128、通道数为3。对于具体坐标[0,1,2]表示第2个通道中第1行第0列的像素值。有时需要对shape变形,如将图像中的数据按一维数组方式排列,这时可以通过重新定义Tensor对象的shape的方式实现。TensorFlow中,函数tf.reshape用于重新定义Tensor的shape。

一维数组在计算机内存中是用一块连续的空间存储,二维数组及更高维数组也是如此。对于高维矩阵,其本质可看成一维数组,只是高维数组存取数据时,需要换算指定的各个维度对应于一维数组的索引。在Reshape过程中,存储数据的顺序不会发生变化,数据依然是同样一批数据,以不同尺度读取数据则得到的是不同的shape数据。

TensorFlow中,函数tf.reshape用于实现Reshape操作,函数原型:

tf.reshape(

tensor,

shape,

name=None

)

其中,tensor为输入Tensor对象;参数shape表示经过Reshape后的shape,数据类型只能为int32或int64。

在库numpy中也有Reshape的实现函数np.reshape,还可以直接用Python代码实现,实现方法是先将高维数组拉伸成一维,再将一维数组重新reshape到指定的shape。

2. 维度交换函数:

对于二维矩阵,将x和y交换的操作称为矩阵转置。二维矩阵的转置是高维矩阵转置的特例,高维Tensor转置需要实现任意维度交换。TensorFlow中,tf.transpose用于实现任意维度的交换。

从Tensor下标的角度来理解,在Tensor[m][n][k]处的数据,经过Transpose操作后,存放位置为Tenso[n][k][m],数据存储的位置发生变化。函数tf.transpose的原型:

tf.transpose(

a,

perm=None,

name='transpose',

conjugate=False

)

各个参数的含义及类型:

· a:Tensor对象,为输入。

· perm:列表类型,表示交换后的维度位置。

· name:字符串类型,表示当前Operation的名称。

· conjugate:bool类型,如果为True,返回tf.conj(tf.transpose(a))。其中,tf.conj的功能为,如果输入是实数,则不做任何操作返回输入;如果输入是复数,则将复数的虚部取反数。

trans_tf=tf.transpose(data_tf,(2,1,0))

3. 维度扩充与消除:

许多场景下需要增加Tensor的维度,增加一个长度为1的维度;而有些场景则希望将Tensor长度为1的维度去掉。

1)维度扩充:

TensorFlow中,函数tf.expand_dims的功能是在Tensor对象shape中任意位置加入新的维度,新加入的维度数据长度为1。函数原型:

tf.expand_dims(

input,

axis=None,

name=None,

dim=None

)

各参数含义及数据类型:

· input:Tensor对象,为输入。

· axis:整数类型,假设input是N维Tensor,那么axis的取值范围为[-1-N,N]。

· name:字符串类型,指定输入Tensor对象名称。

· dim:整数类型,等价于axis,即将弃用。

output_tf=tf.expand_dims(input_tf,axis=1)

2)维度消除:

函数tf.squeeze用于将指定长度为1的维度消除。原型:

tf.squeeze(

input,

axis=None,

name=None,

squeeze_dims=None

)

各参数含义及数据类型:

· input:Tensor对象,为输入。

· axis:列表类型,默认[],列表里的数据类型为int。将列表中指定的索引维度消除,如果索引所指定的维度的长度不为1则抛出异常。假设input是N维Tensor对象,列表中索引取值范围[-N,N]。

· name:字符串类型,指定当前Operation的名称。

· squeeze_dims:等同于参数axis,即将弃用。

output_tf=tf.squeeze(input_tf,axis=[0,2])

4. Tensor对象裁剪:

对于三通道的图像,很容易理解图像裁剪的原理就是在宽和高两个维度截取一个区域,在通道维度保留所有区域。对于一般性的Tensor而言,裁剪就是将指定任意维度区域保留下来,而将不在指定区域的维度数据丢弃。

函数tf.slice用于截取Tensor对象每个维度的指定区域,函数原型:

tf.slice(

input_,

begin,

size,

name=None

)

各个参数的含义及数据类型:

· input_:Tensor对象,为输入。

· begin:数据类型为整数类型的列表,或者是数据类型为int32或int64的Tensor对象。列表中的每个整数用于指定对应维度截取的起始位置。

· size:数据类型为整数类型的列表,或者是数据类型为int32或int64的Tensor对象。列表中的每个整数用于指定对应维度截取的长度。

· name:字符串类型,作为当前Operation对象的名称。

参数begin是从0开始索引,begin[i]表示第i个维度的截取位置,参数size指定截取长度,size[i]表示第i个维度截取的长度。

output_tf=tf.slice(input_tf,[0,1,1],[1,2,1])

5. Tensor对象拼接:

图片可以看成三维Tensor,图片拼接可以在水平方向和垂直方向上做拼接。对于一般性Tensor而言,其拼接即在指定的任意维度方向上的连接。函数tf.concat用于将Tensor对象在任意维度方向上做拼接,原型:

tf.concat(

values,

axis,

name='concat'

)

各个参数的含义及数据类型:

· values:列表类型或者Tensor对象,如果是列表,则列表中存放的是Tensor对象。

· axis:整数或者数据类型为int32的标量Tensor对象,用于指定拼接的维度。

· name:字符串类型,表示当前Operation对象的名称。

output_tf=tf.concat([A_tf,B_tf],axis=0)

Tensor对象在哪个维度做连接,对应长度就等于两个Tensor对应维度的长度之和。

6. tf.stack和tf.unstack:

TensorFlow中,tf.stack的功能是将多个Tensor对象按栈的方式组合成新的Tensor对象,tf.unstack操作则相反。

1)tf.stack的使用:

栈操作是按照将先进入的元素放入栈底后进入的元素放入栈顶的顺序存放数据。tf.stack将传入的Tensor列表按栈顺序入栈,但是没有出栈操作。tf.stack根据指定的维度位置扩充维度,是tf.expand_dims和tf.concat的组合实现。原型:

tf.stack(

values,

axis=0,

name='stack'

)

各个参数的含义及数据类型:

· values:列表类型,列表中存放的是Tensor对象,并且每个Tensor对象的shape和数据类型必须一致。

· axis:整数类型,指定stack操作的维度索引,默认0。假设参数values中的Tensor对象为N维Tensor,那么axis的取值范围为[-(N+1),N+1]。

· name:字符串类型,指定当前Operation对象的名称。

output_tf=tf.stack([A_tf,B_tf,C_tf],axis=0)

2)tf.unstack的使用:

tf.unstack是tf.stack的逆运算,用于将一个Tensor对象在指定维度上拆分成多个Tensor对象,函数原型:

tf.unstack(

value,

num=None,

axis=0,

name='unstack'

)

各个参数含义及类型:

· value:维度大于0的Tensor对象,为输入。

· num:整数类型,指定输出Tensor对象的个数,即参数axis指定维度的长度。如果没有指定,将会自动根据axis指定的维度的长度来获取。

· axis:整数类型,指定执行的维度,默认为0。假设value是N维Tensor对象,那么axis的取值范围为[-N,N]。

· name:字符串类型,指定当前Operation的名称。

output_tf=tf.unstack(input_tf,axis=0)

函数tf.unstack功能可以利用函数tf.slice来实现。对于shape=[A,B,C]的Tensor对象input,执行tf

7. tf.argmax与tf.argmin:

函数tf.argmax的功能是找出指定维度上值最大的索引,而函数tf.argmin用于找出指定维度上值最小的索引。函数原型分别为:

tf.argmax(

input,

axis=None,

name=None,

dimension=None,

output_type=tf.int64

)

tf.argmmin(

input,

axis=None,

name=None,

dimension=None,

output_type=tf.int64

)

各个参数含义及数据类型:

· input:Tensor对象,数据类型只能取float32、float64、int32、uint8、int16、int8、complex64、int64、qint8、quint8、qint32、bfloat16、uint16、complex128、half、uint32、uint64中的一种。

· axis:整数类型或者是数据类型为int32或int64的0维Tensor对象。假设input是N维Tensor对象,那么axis的取值范围维[-N,N],用于指定比较的维度。

· name:字符串类型,用于指定当前Operation对象的名称。

· dimension:该参数已废弃。

· output_type:tf.Dtype类型,只能取tf.int32或tf.int64,表示输出数据类型。

max_tf=tf.argmax(input_tf,axis=0)

三、前馈卷积神经网络:

前馈网络不需要关心梯度和参数更新问题,只需关心输入、输出和当前节点的参数。相比反向传播网络,前馈网络更容易理解。

1. 卷积:

1)卷积原理:

在深度学习中,卷积的定义与数学上的定义有细微区别。卷积核可以看成一个二维矩阵,多个卷积核可以组成N维矩阵。常见的卷积核有7x7、5x5、3x3和1x1。计算卷积的第一步是设置padding方式,即边缘填充方式,常见的有SAME和VALID两种。SAME方式是当卷积核在边缘运算时会在边缘补充0,VALID方式则是不做任何填补,大部分时候padding方式都为SAME。卷积另外一个重要参数是stride,即每一步移动的长度。计算方式为卷积核上每个位置的值与输入Feature Map选中区域的每个位置值相乘,然后求和。

实际应用时,大部分情况都是多通道输入和输出。输入通道数为in_c,输出通道数为out_c,卷积核的数量filter_n

2)卷积输出:

计算卷积之前,输入宽高、卷积核宽高及stride都是已知的,输出宽高及SAME填充规则都是基于输入宽高和stride计算得出。

Stride_x表示水平方向的stride,stride_y表示垂直方向的stride值。输入Feature Map的宽高分别用in_width和in_height表示,输出Feature Map的宽高分别用out_width和out_height表示,卷积核的宽高分别用filter_width和filter_height表示。

TensorFlow中,当Padding=SAME时,输出Feature Map的宽高和输入宽高及stride的关系:

out_width=[in_width/stride_x]

out_height=[in_height/stride_y]

其中数值为向上取整。

TensorFlow中,当Padding=VALID时,输出Feature Map的宽高和输入宽高及stride的关系:

out_width=[(in_width-filter_width+1)/stride_x]

out_height=[(in_height-filter_height+1)/stride_y]

其中数值为向上取整。

输出Feature Map宽高确定后,根据输入Feature Map和输出Feature Map的宽高可以确定Padding=SAME时边界上需要补0的行数pad_height和列数pad_width。计算公式:

pad_width=max{(out_width-1)×stride_x+filter_width-in_width,0}

pad_height=max{(out_height-1)×stride_y+filter_height-in_height,0}

在计算得到需要补0的行数和列数后,行数要平均地分配到上下两个边界,列数要平均地分配到左右两个边界。在存在奇数时,下侧边界会比上侧边界多多分配一行,右侧边界会比左侧边界多分配一行。用pad_top表示上侧需要补0的行数,pad_bottom表示下侧需要补0的行数,pad_left表示左侧需要补0的列数,pad_right表示右侧需要补0的列数。公式:

pad_top=[pad_height/2] # 向下取整

pad_bollom=pad_height-pad_top

pad_left=[pad_width/2] # 向下取整

pad_bollom=pad_width-pad_left

3)空洞卷积:

空洞卷积选择的区域不一定是连续的一块区域,允许间隔一定的长度来选取不同位置的值组成一个卷积区域,间隔长度可以由用户设置。空洞卷积选取卷积区域的元素之间的位置间隔分为水平方向间隔和垂直方向间隔,在Batch维度和通道维度上也可以设置。

相同条件下,使用空洞卷积感受视野更广,如果需要较大的感受视野但同时不想把卷积核宽高设计得太大,可以考虑使用空洞卷积。但空洞卷积选择的卷积区域元素之间不连续,意味着丢失了原始输入数据的连续性特征,在目标物体较小时明显不利。

4)TensorFlow中的卷积计算:

TensorFlow中,卷积函数为tf.nn.conv2d。函数原型:

tf.nn.conv2d(

input,

filter,

strides,

padding,

use_cudnn_on_gpu=True,

data_format='NHWC',

dilations=[1,1,1,1],

name=None

)

各个参数的含义及数据类型:

· input:四维Tensor对象,表示输入数据。数据维度格式可以是[N,H,W,C],即[Batch数量,高度,宽度,通道数],也可以是[N,C,H,W],具体由data_format决定。

· filter:四维Tensor对象,表示卷积核。数据维度格式为[filter_height, filter_width, in_channels, out

· strides:长度为4的一维列表,分别表示input里面每个维度的stride,具体顺序跟data_format有关。

· padding:字符串对象,只能取SAME或者VALID。

· use_cudnn_on_gpu:bool类型,表示GPU是否使用cudnn库,默认True。

· data_format:字符串对象,只能取NHWC或NCHW,指定输入和输出的维度格式,默认NHWC。

· dilations:长度为4的一维列表,表示空洞卷积在每个维度的步长,默认[1,1,1,1]。

· name:字符串对象,指定当前Operation对象的名称。

实现Padding=SAME和stride=1的卷积计算示例:

import tensorflow as tf

import numpy as np

#输入数据,格式CHW

input_data=[[[1,2,3],[2,1,3],[3,2,1]]]

#卷积核,格式[in_c,height,width]

weights_data=[[[1,1,1],[1,1,1],[1,1,1]]]

#对卷积函数封装

def tf_conv2d(input,weights,stride,dilation=1):

conv=tf.nn.conv2d(input,weights,strides=[1,stride,strode,1],dilations=[1,dilation

return conv

#主函数

def main():

const_input=tf.constant(input_data,tf.float32)

const_weights=tf.constant(weights_data,tf.float32)

input=ft.Variable(constant_input,name="input")

#[2,5,5]---->[5,5,2]

input=tf.transpose(input,perm=[1,2,0])

#[5,5,2]---->[1,5,5,2]

input=tf.expand_dims(input,0)

weights=tf.Variable(const_weights,name="weights")

#将卷积核由[in_c,height,width]转为[height,width,in_c],即[1,3,3]--->[3,3,1]

weights=tf.transpose(weights,perm=[1,2,0])

#将卷积核由[height,width,in_c]扩充为[height,width,in_c,out_c],即[3,3,1]--》[3,3,1,1]

weights=tf.expand_dims(weights,3)

#[b,h,w,c]

conv=tf_conv2d(input,weights,stride=1)

#[h,w,c]---->[c,h,w]

rs=tf.transpose(conv[0],peim=[2,0,1])

init=tf.global_variables_initializer()

sess-tf.Session()

sess.run(init)

conv_val=sess.run(rs)

#打印结果,跳过第一个维度Batch

print(conv_val[0])

#主程序入口

if __name__=='__main__':

main()

代码中,定义输入和卷积核均采用CHW格式,比较容易看懂,后面的代码则使用transpose将CHW转换为WHC,卷积结果再转换回来。结果:

[[6. 12. 9.]

[11. 18. 12.]

[8. 12. 7.]]

2. 反卷积:

反卷积Deconvolution就是卷积的逆操作,还称为分数步长卷积、转置卷积等。

1)反卷积原理:

当卷积的stride>1时,得到的输出Feature Map的宽高比输入Feature Map的宽高要小,这可以看成下采样的过程。而反卷积操作可以看成上采样,即输出Feature Map的宽高比输入Feature Map宽高大。

计算反卷积时,首先需要对输入Feature Map执行补0。反卷积也有Padding参数设置,并且也分为SAME和VALID两种,但在反卷积中Padding参数主要用于计算输出Feature Map的宽高。不管反卷积的Padding设置为SAME或VALID,都会对边界补0,并且上下侧边界补0的行数均为反卷积核的高度减1,左右侧边界补0的列数均为反卷积核的宽度减1。反卷积还会在输入Feature Map的每个元素之间插入0,对于每一行,每两个元素之间插入0的数量为行方向的stride-1;对于每一列,每两个元素之间插入0的数量为列方向的stride-1。

计算反卷积过程中,首先是对输入Feature Map每个元素之间和边界插入0,然后对插入的输入做普通卷积运算。

在TensorFlow的反卷积中,Padding方式设置为VALID与SAME的区别主要有两点:

· 用户在设置输出Feature Map的维度时,Padding方式设置为VALID与SAME的计算公式不同。

· 在获取最终输出Feature Map时,如果得到的输出Feature Map的维度与用户设置的维度不同时,SAME方式的Padding需要丢弃一些多余项,而VALID方式需要补0。

2)输出宽高:

反卷积的输出Feature Map的宽高可以根据卷积的输出宽高的计算公式逆向计算出来。

①Padding=SAME时:

在TensorFlow中,反卷积输出Feature Map需要用户指定,为了便于与卷积的输入/输出宽高区分,用de_outW和de_outH分别表示反卷积的输出宽度和输出高度,用de_inW和de_inH分别表示反卷积的输入宽度和输入高度,用de_Sx和de_Sy分别表示反卷积在宽的维度上的stride和在高的维度上的stride。计算公式:

de_outW={x|(de_inW-1)×de_Sx<x≤de_inW×de_Sx}

de_outH={y|(de_inH-1)×de_Sy<y≤de_inH×de_Sy}

在TensorFlow中,如果指定的输出Feature Map的宽高比实际计算得到的宽高小,那么会在实际计算得到的Feature Map中裁剪一块与用户指定的宽高大小相同的区域作为反卷积的输出。

用my_outW和my_outH表示用户设置的宽高,用cpt_outW和cpt_outH分别表示实际计算得到的输出Feature Map的宽高,用left和top表示从计算得到的输出Feature Map中裁剪的有效区域与左边界间隔的列数及与上边界间隔的行数。如果my_outW<cpt_outW且my_outH<cpt_outH,那么裁剪的起始位置的left和top的计算公式:

left=[(cpt_outW-my_outW)/2] # 向下取整

top=[(cpt_outH-my_outH)/2] # 向下取整

有了left和top后,相当于有了裁剪起始位置,根据my_outW和my_outH可以计算得到裁剪区域。

理解裁剪区域的方式,如果实际计算得到的宽高减去用户指定的宽高结果为偶数,那么裁剪区域就是正中间的区域;如果是奇数,那么右边比左边多丢弃一列,下边比上边多丢弃一行。

②Padding=VALID时:

用de_fW和de_fH分别表示反卷积核的宽和高,计算公式:

de_outW={x|(de_inW-1)×de_S+de_fW-1<x≤de_inW×de_Sx+de_fW-1}

de_outH={y|(de_inH-1)×de_Sy+de_fH-1<y≤de_inH×de_Sy+de_fH-1}

当Padding=VALID时,用户指定的输出宽高可能会比实际计算得到的Feature Map的宽高大,那么会在右侧补my_outW-cpt_outW列0,在下侧补my_outH-cpy_outH行0。如果用户指定输出宽高比实际宽高小,那么会报错。

3)TensorFlow中的反卷积计算:

在TensorFlow中,反卷积函数tf.nn.conv2d_transpose用于反卷积计算。函数原型为:

tf.nn.conv2d_transpose(

value,

filter,

out_shape,

strides,

padding='SAME',

use_cudnn_on_gpu=True,

data_format='NHWC',

name=None

)

各个参数的含义及数据类型:

· value:四维Tensor对象,表示输入数据。数据维度可以是[N,H,W,C],即[Batch数量,高度,宽度,通道数],也可以是[N,C,H,W],具体方式由data_format决定。

· filter:四维Tensor对象,表示卷积核,数据维度格式[filter_height, filter_width, out_channels, in_channels]。

· out_shape:长度为4的一维列表,分别代表input里面每个维度对应的输出维度大小。

· stride:长度为4的一维列表,分别代表input里面每个维度的stride。

· padding:字符串对象,只能取字符串SAME或VALID。

· data_format:字符串对象,只能取NHWC或NCHW,指定输入和输出的维度格式,默认NHWC。

· name:字符串对象,指定当前反卷积操作的名称。

反卷积示例:

import tensorflow as tf

import numpy as np

#输入数据,shape为[channels,height,width]CHW

input_data=[[[1,0,1],[0,2,1],[1,1,0]]]

#卷积核,格式[out_c,in_c,height,width]

weights_data=[[[[1,0,1],[-1,1,0],[0,-1,0]]],[[[1,0,2],[-2,1,1],[1,-1,0]]]]

#对卷积函数封装

def tf_conv2d_transpose(input,weights,stride=3,padding='SAME',output_hw=None):

#input_shape=[n,height,width,channel]

in_b,in_h,in_w,in_c=input.get_shape().as_list()

#weights shape=[height,width,out_c,in_c]

w_h,w_w,w_out_c,w_in_c=weight.get_shape().as_list()

if output_hw is None:

#根据padding计算输出shape

if padding=='SAME':

output_shape=[in_b,in_h*stride,in_w*stride,w_out_c[2]]

else:

output_shape=[in_b,in_h*stride+w_h-1,w_out_c*stride+w_w-1,w_out_c[2]]

else:

output_shape=[in_b,output_hw[0],output_hw[1],w_out_c]

deconv=tf.nn.conv2d_transpose(input,weights,output_shape_shape,strides=[1,stride,1],padding=padding)

return deconv

#主函数

def main():

weights_np=np.asarray(weights_data,np.float32)

#将输入的每个卷积核旋转180度

weights_np=np.rot90(weights_np,2,(2,3))

const_input=tf.constant(input_data,tf.float32)

const_weights=tf.constant(weights_np,tf.float32)

input=ft.Variable(constant_input,name="input")

#[c,h,w]---->[h,w,c]

input=tf.transpose(input,perm=[1,2,0])

#[h,w,c]---->[n,h,w,c]

input=tf.expand_dims(input,0)

#weights shape=[out_c,in_c,h,w]

weights=tf.Variable(const_weights,name="weights")

#将卷积核由[out_c,in_c,h,w]转为[h,w,out_c,in_c]

weights=tf.transpose(weights,perm=(2,3,0,1))

#执行反卷积

deconv=tf_conv2d_transpose(input,weights,stride=2,padding='VALID',output_hw=[7,7])

init=tf.global_variables_initializer()

sess=tf.Session()

sess.run(init)

deconv_val=sess.run(deconv)

hwc=deconv_val[0]

h,w,c=hwc.shape

for i in range(c):

print(hwc[:,:,i])

#主程序入口

if __name__=='__main__':

main()

代码中,将自定义的反卷积核旋转180°,这是计算反卷积时传入反卷积函数之前必须要做的一步,要不然得到的结果会与预期有差别。实际项目中,反卷积核的参数都是通过学习得到的,不需要传入,所以不需要关心传入卷积核是否需要旋转的问题。

3. Batch Normalization:

为了充分利用GPU的并行处理能力,TensorFlow会同时将多张图片一起传入网络进行训练,多张图片称为一个batch。采用这种batch的方式不仅为了利用GPU的并行能力,更是为了能让训练相对稳定一些。

1)Batch Normalization原理:

对于一批具有相同特征的数据集,其包含的数据共性服从某个分布,而每个个体之间可能存在很大差异。但是在训练过程中,如果将两张图片先后单独传入网络训练,由于数据分布可能相差比较大,训练过程中模型学习到的分布不断发生偏移,可能会带来梯度消失或梯度发散的问题,这会给网络训练带来困难。

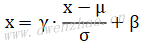

在传入网络之前,如果能将数据统一规范化,每次传入网络的数据都服从某个分布,那将会使得网络收敛得更快。Batch Normalization就是做规范化的一层网络层,每次传入网络层时,将输入x中的每个通道(多张图中对应的每个通道)求平均值μ和方差σ2,然后根据均值和方差对数据做转化,使得输入服从标准正态分布,公式:x=(x-μ)/σ。

但是,对于每一层网络来说,如果强制将输入转为服从正态分布的数据,就会将网络的能力消弱,因为每层网络的输入的最佳分布不一定呈标准正态分布。为了解决这个问题,可以在标准化公式中添加缩放系数γ和偏移系数β,公式:

2)TensorFlow中使用Batch Normalization:

TensorFlow中,Batch Normalization的接口函数为tf.nn.batch_normalization。函数原型:

tf.nn.batch_normalization(

x,

mean,

variance,

offset,

scale,

variance_epsilon,

name=None

)各个参数的含义及数据类型:

· x:Tensor对象,输入Feature Map,公式一般为[Batch,Height,Width,Channel]。

· mean:Tensor对象,表示均值,格式一般为长度为通道数的一维数组。

· variance:Tensor对象,表示方差,格式一般为长度为通道数的一维数组。

· offset:Tensor对象,表示偏移量参数,格式一般为长度为通道数的一维数组。

· scale:Tensor对象,表示缩放参数,格式一般为长度为通道数的一维数组。

· variance_epsilon:float类型,为避免分母为0,需要对分母加一个很小的数,如0.001。

· name:字符串类型,用于指定当前Operation对象的名称。

函数tf.nn.batch_normalization相对比较底层,需要用户传入均值、方差、缩放系数scale和偏移系数offset。如果想通过移动平均线的方式来计算均值和方差,需要用户自己实现。为了简化这一过程,TensorFlow提供了另一个函数tf.layers.batch_normalization,使用这个函数可以不关心均值、方差、缩放系数及偏移量的计算和设置方式。函数原型:

tf.layers.batch_normalization(

inputs,

axis=-1,

momentum=0.99,

epsilon=0.001,

center=True,

scale=True,

beta_initializer=tf.zeros_initializer(),

gamma_initializer=tf.ones_initializer(),

moving_mean__initializer=tf.zeros_initializer(),

moving_variance__initializer=tf.ones_initializer(),

beta_regularizer=None,

gamma_regularizer=None,

beta_constraint=None,

gamma_constraint=None,

training=False,

trainable=True,

name=None,

reuse=None,

renorm=False,

renorm_clipping=Nobe,

renorm_momentum=0.99,

fused=None,

virtual_batch_size=None,

adjustment=None

)函数的参数比较多,常用参数含义及数据类型:

· inputs:Tensor对象,表示输入Feature Map,格式一般为[Batch,Height,Width,Channel]。

· momentum:float类型,平滑算法中,当前待平缓的值(如均值、方差)相比相比于上一个值的权重。

· epsilon:float类型,为了避免分母为0,需要对分母加一个很小的数,默认0.001。

· center:bool类型,如果为True,表示要加偏移量参数offset,默认为True。

· scale:bool类型,如果为True,表示要加缩放系数scale,默认为True。

下面分别使用tf.nn.batch_normalization和tf.layers.batch_normalization函数来实现Batch Normalization。暂时将缩放参数scale设为1,偏移量offset设为0,使用TensorFlow框架计算Batch Normalization代码:

import tensorflow as tf

import numpy as np

#shape=[batch,c,h,w]

input=[

#第1张图,2通道,宽高2*2

[

#第1个通道

[[1,2],[2,1]],

#第2个通道

[[3,4],[4,3]]],

#第2张图,2通道,宽高2*2

[

#第1个通道

[[5,6],[6,5]],

#第2个通道

[[7.8],[8,7]]]]

input_np=np.array(input,np.float32)

input_tf=constant(input_np,tf.float32)

#[b,c,h,w]---->[b,h,w,c]

input_tf=tf.transpose(input_tf,perm=(0,2,3,1))

_,_,_,c=input_tf.get_shape().as_list()

scale=tf.ones((c,),tf.float32)

offet=tf.zeros((c,),tf.float32)

mean,var=tf.nnmoments(input_tf,[0,1,2])

output=tf.nn.batch_normalization(input_tf,mean,var,0ffset,scale,variance_epsilon=0.001,name='bn')

with tf.Session() as sess:

m,v,out=sess.run([mean,var,output])

print('mean=',m)

print('var=',v)

#[b,h,w,c]--->[b,c,h,w]

out=np.transpose(out,axes=(0,3,1,2))

print('output=\n',out)代码中,为了便于阅读,输入使用[batch,channel,height,width]格式存储,而在使用TensorFlow时需要转为[batch,height,width,channel]格式,才能使计算结果与预期结果对应上。但输出结果为了便于阅读,又把格式转为[batch,channel,height,width]。

注意,在求Batch Normalization时分母不是直接将方差代入,而是用标准差,即方差的算术平方根。

①使用tf.nn.batch_normalization:

前面示例是使用tf.nn.batch_normalization来实现Batch Normalization。但在实际项目中,缩放参数scale和偏移参数offset不是固定的,而是需要通过学习得到,即scale和offset必须是tf.Variable对象,而且是trainable的。

将缩放参数和偏移参数变量、求均值方差及Batch Normalization封装成一个函数,便于Batch Normalization简单调用:

def batch_norm(x,momentum=0.99,epsilon=0.001,is_training=True):

_,_,_,c=x.get_shape().as_list()

#定义缩放变量gamma和偏移变量beta

gamma=tf.get_variable('gamma',(c,),dtype=tf.float32,initializer=tf.ones_initializer,trainable=is_training)

beta=tf.get_variable('beta',(c,),dtype=tf.float32,initializer=tf.zeros_initializer,trainable=is_training)

#计算均值与方差

mean,variance=tf.nn.moments(x,[0,1,2])

#如果是训练阶段,用移动平均线moving_average来对均值和方差做平滑

if is_training:

moving_mean=tf.get_variable('moving_mean',

moving_variance=tf.get_variable('moving_variance',

update_moving_mean=moving_averages.assign_moving_average(moving_mean,mean,momentum)

update_moving_variance=moving_averages.assign_moving_average(moving_variance,variance,momentum)

tf.add_to_collection(tf.GraphKeys.UPDATE_OPS,update_moving_mean)

tf.add_to_collection(tf.GraphKeys.UPDATE_OPS,update_moving_variance)

mean,variance=moving_mean,moving_variance

x=tf.nn.batch_normalization(x,mean,variance,beta,gamma,variance_epsilon=epsilon)

return x上面代码根据当前是否是训练来决定是直接计算均值方差,还是用平滑算法来替代均值方差,代码中分别用1和0初始化缩放变量gamma和偏移变量beta。计算Batch Normalization时,方差是分母,为了防止方差为0,会对方差加一个非常小的值epsilon,默认0.001。下面示例使用上述的函数封装:

import tensorflow as tf

import numpy as np

#shape=[batch,c,h,w]

input=[

#第1张图,2通道,宽高2*2

[

#第1个通道

[[1,2],[2,1]],

#第2个通道

[[3,4],[4,3]]],

#第2张图,2通道,宽高2*2

[

#第1个通道

[[5,6],[6,5]],

#第2个通道

[[7.8],[8,7]]]]

input_np=np.array(input,np.float32)

input_tf=tf.constant(input_np,tf.float32)

#[b,c,h,w]---->[b,h,w,c]

input_tf=tf.transpose(input_tf,perm=(0,2,3,1))

output_tf=batch_norm(input_tf,is_trainning=False)

with tf.Session() as sess:

sess.run([tf.global_variables_initializer())

output=sess.run(output_tf)

output=np.transpose(output,axes=(0,3,1,2))

print(output)②使用tf.layers.batch_normalization:

函数tf.layers.batch_normalization是对tf.nn.batch_normalization的封装,其中做的运算与上面自定义的封装函数差不多。使用时大部分参数不用考虑,只关心几个参数的设置。示例:

import tensorflow as tf

import numpy as np

#shape=[batch,c,h,w]

input=[

#第1张图,2通道,宽高2*2

[

#第1个通道

[[1,2],[2,1]],

#第2个通道

[[3,4],[4,3]]],

#第2张图,2通道,宽高2*2

[

#第1个通道

[[5,6],[6,5]],

#第2个通道

[[7.8],[8,7]]]]

input_np=np.array(input,np.float32)

input_tf=constant(input_np,tf.float32)

#[b,c,h,w]---->[b,h,w,c]

input_tf=tf.transpose(input_tf,perm=(0,2,3,1))

output_tf=tf.layers.batch_normalization(input_tf,momentum=0.99,epsilon=0.001,trainning=True)

with tf.Session() as sess:

sess.run([tf.global_variables_initializer())

output=sess.run(output_tf)

output=np.transpose(output,axes=(0,3,1,2))

print(output)使用tf.layers.batch_normalization时需要注意,训练阶段一定要将training设置为True,在Inference阶段一定要将training设置为False,否则得到的结果可能不正确。

TensorFlow中还有一个对Batch Normalization的封装函数tf.contrib.layers.batch_norm,用法与tf

③使用注意事项:

在TensorFlow中,实现Batch Normalization时用到了平滑算法来对均值和方差进行优化。平滑算法主要是根据当前均值和方差及在此前计算的均值和方差的值,重新计算新的均值和方差,并且更新均值和方差变量。

值得主要的是,在训练阶段,更新平滑后的均值和方差op放到了集合tf.GraphKeys.UPDATE _OPS中,这会使更新均值和方差的op与当前训练op没有依赖关系,从图的角度来理解就是从根节点到叶子节点之间的路经没有包含更新均值和方差的计算节点。

在最优化output时,更新均值和方差这一步并没有被执行,这就是导致虽然训练时很好,但在Inference阶段发现得到的结果是错误的,因为均值和方差都还是初始化的值,在学习过程中并没有得到更新。为了避免这个问题,需要在训练时强制执行更新均值和方差的操作,有两个方案可以选择:

⑴方案1:在执行最小化loss之前,先强制执行tf.GraphKeys.UPDATE_OPS集合里面的op,即为最小化loss操作添加依赖关系,参考代码:

update_ope=tf.get_collection(GraphKeys.UPDATE_OPS)

with tf.control_dependencies(update_ops):

train_op=optimizer.minimize(loss)

sess.run([train_op])⑵方案2:将更新均值和方差的操作与最小化loss操作一起放入tf.Session的run还是中执行,参考代码:

extra_update_ops=tf.get_collection(tf.GraphKeys.UPDATE_OPS)

sess.run([train_op,extra_update_ops])

4. Instance Normalization:

Instance Normalization也是为数据做标准化。

1)Instance Normalization原理:

Instance Normalization的计算公式与Batch Normalization的计算公式一样,区别在于均值和方差的计算方法。Batch Normalization是对输入的一批Batch中对应的通道求均值和方差,而Instance Normalization是对每个Batch中的每个通道单独求均值和方差,得到均值μ和方差σ后,依然需要一个缩放参数scale(γ)和偏移参数offset(β)。计算公式:

当然,二者的缩放参数scale和偏移参数offset都是一样的,都是通过训练学习得到的,一旦模型训练完成,scale和offset也就确定了。

2)TensorFlow中使用Instance Normalization:

TensorFlow中,Instance Normalization函数接口tf.contrib.layers.instance_norm,函数原型:

tf.contrib.layers.instance_norm(

inputs,

center=True,

scale=True,

epsilon=1e-06,

activation_fn=None,

param_initializers=None,

reuse=None,

variables_collections=None,

outputs_collections=None,

trainable=True,

data_format=DATA_FORMAT_NHWC,

scope=None

)各个参数含义及数据类型:

· inputs:Tensor对象,维度大于2的任意Tensor,在卷积神经网络中一般为4维,[N,H,W,C]。

· center:bool类型,如果为True,表示要添加偏移参数offset,默认为True。

· scale:bool类型,如果为True,表示要添加缩放参数scale,默认True。如果后面一层接入的是线性变化(如relu),那么缩放参数scale不会加入,因为线性变化本身也是做缩放。

· epsilon:float类型,为避免分母为0,需要对分母加一个很小的数,默认0.000001。

· activation_fn:函数对象,用于在当前层后面添加一个激活函数,默认None,即不添加。

· param_initializers:字典对象,参数初始化参数,通过字典来指定缩放参数gamma(scale)和偏移参数beta(offset)设置默认初始值。字典对应的key分布为gamma字符串和beta字符串。

· reuse:bool类型,指定当前层变量是否是reuse,如果为True,需要指定scope。

· variables_collections:Tensor对象,当前层的变量存放到指定的集合中。

· outputs_collections:Tensor对象,当前层的输出存放到指定的集合中。

· trainable:bool类型,指定当前层参数是否参与训练。

· data_format:字符串类型,数据维度格式,默认NHWC。

· scope:variable_scope对象,当前层的variable_scope。

先使用TensorFlow的基本函数来自定义Instance Normalization,代码为:

import tensorflow as tf

import numpy as np

#shape=[batch,c,h,w]

input=[

#第1张图,2通道,宽高2*2

[

#第1个通道

[[1,2],[2,1]],

#第2个通道

[[3,4],[4,3]]],

#第2张图,2通道,宽高2*2

[

#第1个通道

[[5,6],[6,5]],

#第2个通道

[[7.8],[8,7]]]]

def instance_norm(x,epsilon=1e-6):

mean,var=tf.nn.moments(x,[1,2],keep_dims=True)

#定义缩放变量scale和偏移变量offset

scale=tf.get_variable('scale',[x.get_shape()[-1]],initializer=constant_initializer(1.0))

offset=tf.get_variable('offset',[x.get_shape()[-1]],initializer=constant_initializer(0.0))

out=scale*tf.div(x-mean,tf.squrt(var+epsilon))+offset

return out,mean,var

input_np=np.array(input,np.float32)

input_tf=tf.constant(input_np,tf.float32)

#[b,c,h,w]---->[b,h,w,c]

input_tf=tf.transpose(input_tf,perm=(0,2,3,1))

output_tf,mean_tf,var_tf=instance_norm(input_tf)

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

output,mean,var=sess.run([output_tf,mean_tf,var_tf])

output=np.transpose(output,axes=(0,3,1,2))

print('mean=',mean)

print('var=',var)

print('output=\n',output)然后使用tf.contrib.layers.instance_norm函数来计算Instance Normalization,示例代码:

import tensorflow as tf

import numpy as np

#shape=[batch,c,h,w]

input=[

#第1张图,2通道,宽高2*2

[

#第1个通道

[[1,2],[2,1]],

#第2个通道

[[3,4],[4,3]]],

#第2张图,2通道,宽高2*2

[

#第1个通道

[[5,6],[6,5]],

#第2个通道

[[7.8],[8,7]]]]

input_np=np.array(input,np.float32)

input_tf=tf.constant(input_np,tf.float32)

#[b,c,h,w]---->[b,h,w,c]

input_tf=tf.transpose(input_tf,perm=(0,2,3,1))

initializers={'gamma':tf.ones_initializer,'beta':tf.zeros_initializer}

output_tf=tf.contrib.layers.instance_norm(input_tf,center=True,scale=True,epsilon=1e-06,param_initializers=initializers,trainable=True)

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

output=sess.run(output_tf)

output=np.transpose(output,axes=(0,3,1,2))

print(output)如果需要对Instance Normalization里面的参数做其他运算控制,推荐使用自定义函数方式;如果不关心Instance Normalization里面的参数细节,推荐用tf.contrib.layers.instance_norm函数直接调用,相对比较简单,不容易出错。

5. 全连接层:

全连接层本质就是线性方程组问题。

1)全连接层原理:

对全连接层的简单描述,就是将长度为M的向量通过M×N个权重变成长度为n的向量。全连接层可以看成维度空间映射,也可以看成“分类器”,将M个输入分为N类。

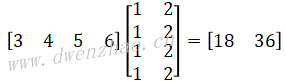

假设有长度为4的输入向量(3,4,5,6),要经过全连接层计算得到输出为2的向量,对应权重为(1,1,1,1)和(2,2,2,2),则全连接层计算过程为:

在TensorFlow中,可以使用函数tf.layers.dense来计算全连接层,函数原型:

tf.layers.dense(

inputs,

units,

activation=None,

use_bias=True,

kernel_initializer=None,

bias_initializer=tf.zeros_initializer(),

kernel_regularizer=None,

bias_regularizer=None,

activity_regularizer=None,

kernel_constraint=None,

bias_constraint=None,

trainable=True,

name=None,

reuse=None

)各个参数的含义及数据类型:

· inputs:Tensor对象,维度大于2的任意Tensor,其中第1个维度一般是Batch,第2个维度是对应的一维向量。

· units:整型或长整型,表示输出向量的长度。

· activation:函数类型,表示全连接层后面连接的激活函数。

· use_bias:bool类型,表示是否添加偏移量。

· kernel_initializer:函数类型,权重初始化函数。

· bias_initializer:函数类型,偏移量参数初始化函数。

· kernel_regularizer:函数类型,权重矩阵的正则化函数。

· bias_regularizer:函数类型,偏移量的正则化函数。

· activity_regularizer:函数类型,输出的正则化函数。

· kernel_constraint:函数类型,权重矩阵的约束项。

· bias_constraint:函数类型,偏移量的约束项。

· trainable:bool类型,指定当前层参数是否参与训练。

· name:字符串类型,当前层的名称。

· reuse:bool类型,是否重用当前层参数变量。

函数的参数虽然很多,但实际常用到的参数只有少数几个。示例:

import tensorflow as tf

import numpy as np

#input shape=[batch,length]=[1,4]

input=[[3,4,5,6]]

#weights shape=[]

weights=[[1,1,1,1],[2,2,2,2]]

input_tf=tf.constant(input,dtype=tf.float32)

#转置,为了计算input*weights

weights=np.transpose(weights,(1,0))

weight_init=tf.constant_initializer(weights)

#[1,4]---->[1,2]

output_tf=tf.layers.dense(input_tf,2,kernel_initializer=weights_init,name='fc')

print(output_tf)

with tf.Session() as sess:

#初始化变量

sess.run(tf.global_variables_initializer())

#执行全连接层计算,得到结果

output=sess.run(output_tf)

print(output)使用函数tf.layers.dense计算全连接层时,按output=input×WT方式进行矩阵相乘,因此代码中对权重矩阵做了转置,后面将定义的权重数据作为初始值赋值给全连接层权重,并执行全连接层计算。输出结果:

[[18. 36.]]

6. 激活函数:

在生物学理论中,大脑中有大量神经元,每个神经元功能不同。当有信号传入时,有些神经元会变得很活跃,但有些神经元却不做任何表现,激活函数与这个过程类似。激活函数也将需要处理的信号往后传输,将不关心的信号丢弃。激活函数是非线性函数,有很多种。

1)激活函数的作用:

在神经网络中,每一层的计算都是线性函数,因此不管网络有多少层,其本质都相当于是一层线性函数计算,这严重消弱了神经网络的能力。因此需要在每一层加入非线性函数,增强神经网络的表达能力和模型学习能力。

在神经网络中,传入的信号可能有很多特征,希望保留关心的特征并且淡化不关心的特征。激活函数能在训练过程中根据loss和梯度数据,将不关心的特征变小并把关心的特征往后传递,这能够起到自动特征提取的作用。激活函数具有的性质:

· 非线性:激活层需要非线性才有意义

· 可微性:在训练模型时,反向传播需要根据每一层的梯度更新权值,因此需要保证激活函数可微

· 单调性:单调性能简化网络结构,并且保证单程网络是凸函数。

· 值域在固定常数区间:激活函数的输出在固定常数区间会使得梯度更新算法更加稳定。

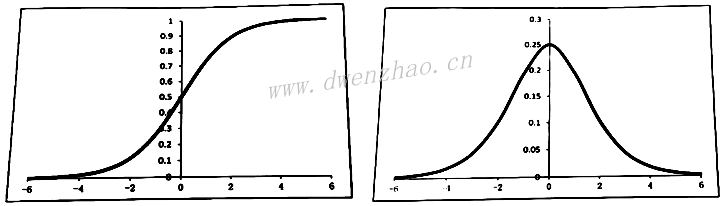

目前主流的激活函数是分段的线性函数(如relu)和指数形式的非线性函数(如Sigmoid)。

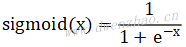

2)Sigmoid函数:

Sigmoid函数的值域为(0,1),也就是无论输入多大或多小,经过Sigmoid后将处于(0,1)区间。函数表达式:

Sigmoid函数存在一些不足,其导数值域在0到0.25之间,导致反向传播过程中,每经过一次Sigmoid函数,传播的梯度更新取值会变成上一层的1/4。随着层数的增多,往前传播的梯度趋于0,即Sigmoid函数会产生梯度消失的问题。

另一个问题是,由于Sigmoid函数的值域是(0,1),意味着经过Sigmoid函数后输出值永远是大于0而没有小于0的输出,并且被束缚在(0,1)区间,这会导致训练过程中梯度变得不稳定。

虽然Sigmoid存在一些缺点,但如果只是在网络最后一层使用Sigmoid函数并不会受到这些缺点影响,比如在分类模型中,最后一层需要将数据规范化到(0,1),往往都是采用Sigmoid函数。

TensorFlow中,可以通过tf.nn.sigmoid函数或tf.sigmoid函数来使用Sigmoid计算。这两个函数的参数一致,tf.sigmoid函数的原型:

tf.sigmoid(

x,

name=None

)各个参数含义及数据类型:

· x:Tensor对象,任意维度的Tensor对象,存储的数据类型只能是float16、float32、float64、complex64、complex128中的一种。

· name:字符串类型,用于指定当前Sigmoid计算的名称。

3)Tanh函数:

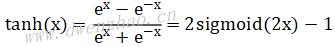

Tanh函数的值域为(-1,1),无论输入多大或多小,经过Tanh后将处于(-1,1)区间。函数表达式:

在TensorFlow中,可以通过函数tf.nn.tanh和tf.tanh计算Tanh,这两个函数的参数和用法是一样的。Tf.tanh的函数原型:

tf.tanh(

x,

name=None

)各个参数的含义及数据类型:

· x:Tensor对象,任意维度的Tensor对象,存储的数据类型只能是float16、float32、double、complex64、complex128中的一种。

· name:字符串类型,用于指定当前Tanh计算的名称。

4)ReLU函数:

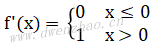

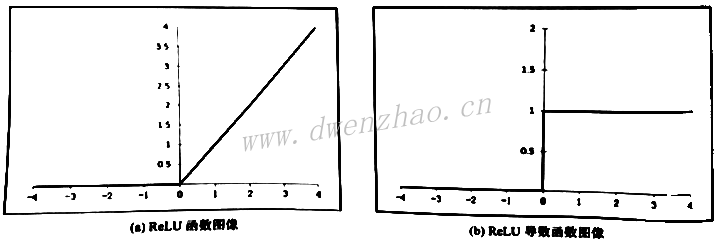

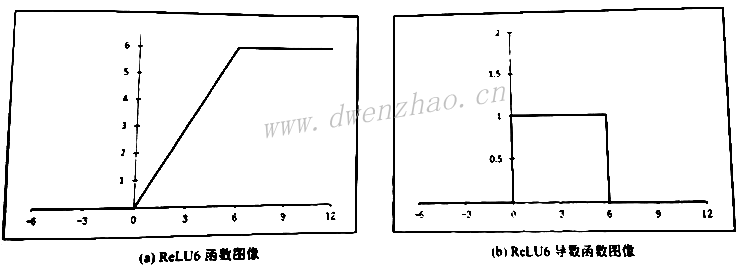

ReLU函数的全称是线性整流函数(Rectified Linear Unit),或者称为修正线性单元,是分段线性函数,将小于0的数置为0,大于0的数不做修改。ReLU是在卷积神经网络中最常使用、最受欢迎的激活函数。ReLU函数的函数表达式f(x)=max(0,x),而导数表达式为:

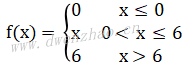

ReLU函数还有其他变种,如ReLU6,函数表达式:

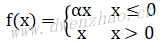

ReLU虽然有其优势,但也有一些不足,主要是虽然前期可以加快收敛速度,但是在训练后期非常脆弱,很容易出现梯度为0的情况。这主要是因为ReLU函数中小于0的梯度为0,即使反向传播的梯度很大,经过ReLU后也变为0。为了解决这个问题,出现了ReLU的改进版--Leaky-ReLU,其函数表达式为:

实际项目中,有时候并不需要逐个进行ReLU实验,因为在某些应用领域,前辈已经通过大量实验得出了最合适得选择。

7. 池化层:

当卷积的stride参数大于1,得到的输出Feature Map的宽高比输入的Feature Map要小,可以看成下采样的过程。在卷积神经网络中,池化层(Pooling层)主要用来做下采样的操作。

1)池化层原理:

池化层操作与卷积操作过程类似,不同的是池化层不需要参数与输入进行计算。池化层有个窗口概念,窗口是用于设置每个被选取做pooling操作的区域的参数,与卷积计算中卷积核的宽高很像。池化层也有stride和padding参数,含义与卷积计算中的基本一致。

当Padding方式为SAME时,池化层会在边界填充,但边界填充的数不会参与计算,只是用于占位。边界填充的行与列的数量计算公式与卷积补0的行与列的数量计算公式一致。

Padding方式为VALID时,不会做填充操作,当有剩余行和列时会被丢弃。关于输出宽高与输入、stride、卷积核及Padding的关系也与卷积一致。

池化层有最大值池化Max Pooling和均值池化Avg Pooling。在计算最大值池化和均值池化时,边界补的数只是为了方便计算输出的宽高。实际上可以将边界填充的区域看成不参与计算的区域,最大值池化边界是镜像填充,均值池化是边界补0。最大值池化中,边界填充的数相当于填充负无穷;均值池化中,只会将当前窗口中非填充区域的所有元素的均值作为输出。

最大值池化,就是选取输入数据在窗口中的最大值作为输出,并存放到输出的对应位置;而均值池化,则是计算输入数据在窗口中数据的均值作为输出,并存放到输出的对应位置。

2)TensorFlow中使用池化:

常见的池化层有最大值池化和均值池化。TensorFlow中提供了池化层函数接口,tf.nn.max _pool函数对应最大值池化,tf.nn.avg_pool对应均值池化。函数原型:

tf.nn.max_pool(

value,

ksize,

stride,

padding,

data_format='NHWC',

name=None

)

tf.nn.avg_pool(

value,

ksize,

strides,

padding,

data_format='NHWC',

name=None

)

两个函数的参数一致,不同之处在于一个是取窗口中的最大值,一个是取窗口内所有元素的均值。参数含义与数据类型:

· value:四维Tensor对象,为输入,每个维度的含义由data_format指定。

· ksize:一维list,长度为4的列表,表示在data_format指定的每个维度上取的窗口的大小。

· strides:一维list,长度为4的列表,表示在data_format指定的每个维度上的stride的大小。

· padding:字符串类型,只能取SAME或VALID。

· data_format:字符串类型,支持NHWC、NCHW、NCHW_VECT_C格式。

· name:字符串类型,表示当前Pooling操作节点的名称。

最大值池化边界是镜像填充,均值池化是边界补0。示例代码:

import tensorflow as tf

import numpy as np

input=[[[[-1,-2,3,1],[-2,-1,2,1],[3,2,-1,-2],[4,1,-4,-9]]]]

def pooling(input,pool_type,ksize,stride,padding)

stride=[1,stride,stride,1]

ksize=[1,ksize,ksize,1]

output=None

if pool_tyep=='MAX_POOL':

output=tf.nn.max_pool(input,ksize,stride,padding)

elif pool_type=='AVG_POOL':

output=tf.nn.avg_pool(input,ksize,stride,padding)

else:

raise "Unknow "+str(pool_type)

return output

input_tf=tf.constant(np.array(input),tf.float32)

input_tf=tf.transpose(input_tf,perm=(0,2,3,1))

output_tf=pooling(input_tf,'MAX_POOL',ksize=3,stride=2,padding='SAME')

#output_tf=pooling(input_tf,'MAX_POOL',ksize=3,stride=2,padding='VALID')

#output_tf=pooling(input_tf,'AVG_POOL',ksize=3,stride=2,padding='SAME')

#output_tf=pooling(input_tf,'AVG_POOL',ksize=3,stride=2,padding='VALID')

with tf.Session() as sess:

output=sess.run(output_tf)

output=np.transpose(output,axis=(0,3,1,2))

print(output)

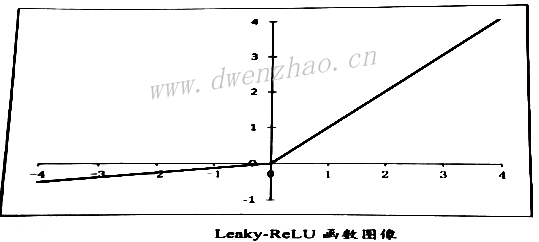

8. Dropout:

在深度神经网络中,如果参数过多而且训练样本较少时,很容易过拟合。也就是说,训练集上的数据学得很好,但是测试集却很差,即泛化能力差。Dropout就是为了防止过拟合的一种操作。

1)Dropout的作用:

深度神经网络中,训练的目的是让网络的最终输出与真实的Label无限接近。每一层的参数与其上一层的参数紧密相关,对于一个训练好的模型,如果将某一层参数做修改,那么模型最终的输出与未修改之前的输出千差万别。也就是说,每个神经元相互之间共适应性很强。各个神经元之间相互协调,共同促进整个网络模型收敛。但有时候,正是因为各个神经元之间协调得太好,这种协调没有对未知数据兼容,导致模型过拟合。

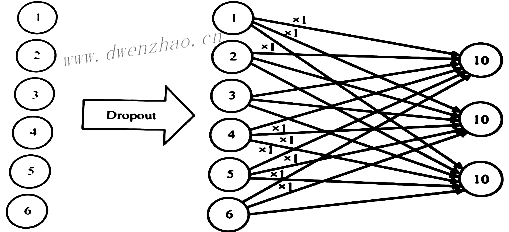

为了防止各个神经元之间过于依赖,Dropout在训练过程中,会随机隐藏一些神经元。在卷积神经网络中,Dropout一般用在全连接层,其他层一般不用Dropout。Dropout在训练过程中得操作如图所示,其中虚线部分表示被隐藏的节点:

在训练阶段才用到Dropout,当模型训练完成后,Dropout层不能再继续作用在模型中。也就是说,在训练阶段Dropout概率参数取值为(0,1),即被隐藏概率在0和1之间,但是在测试和验证阶段要将概率参数设为1,即所有神经元都不被隐藏。在训练阶段,并不是固定选择被隐藏的神经元,而是通过随机选择神经元使其被隐藏。

2)TensorFlow中使用Dropout:

在TensorFlow中,函数tf.nn.dropout用于执行Dropout操作。函数原型:

tf.nn.dropout(

x,

keep_prob,

noise_shape=None,

seed=None,

name=None

)各个参数含义及数据类型:

· x:Tensor对象,数据类型为浮点型的Tensor。

· keep_prob:Tensor对象,取值为[0,1]的数,表示当前节点不被隐藏的概率。

· noise_shape:Tensor对象,一维整型向量,表示随机生成的隐藏和不隐藏的标识的shape。

· seed:整数类型,用于裁剪随机种子。

· name:字符串类型,当前Dropout操作的名称。

下面以全连接为例,假设全连接层输入的有6个节点,分别为[1,2,3,4,5,6],输出有3个节点,那么一共有6×3=18个参数。为了简化理解不失一般性,假设所有的参数均为1,那么全连接层计算,经过Dropout的计算过程如图:

import tensorflow as tf

input=[[1,2,3,4,5,6]]

input_tf=tf.constant(input,tf.float32)

#将系数全部设置为1

weights_tf=tf.ones(shape=[6,3],name="Weights")

#将输入的每个元素以0.5概率隐藏后,作为新的输入

input_tf=tf.nn.dropout(input_tf,keep_prob=0.5)

#对新的输入做矩阵乘法

output_tf=tf.matmul(input_tf,weights_tf)

with tf.Session() as sess:

output=sess.run(output_tf)

#由于随机性,每次打印的结果不一样

print(output)需要注意,在测试或者验证阶段,需要将keep_prob参数设置为1。由于随机性,每次输出的结果都不一样。

四、常见卷积神经网络:

近些年,卷积神经网络经历了高速发展,研究人员总结出了一些高效、快速及易收敛等特性的卷积神经网络结构,如MobileNet、ResNet、DenseNet等。

1. 移动端定制卷积神经网络MobileNet:

MobileNet是Google在2017年提出的一种适合移动端运行的网络结构,在图像分类、目标检测及图像分割等领域有着巨大优势,2018年进一步提出MobileNet V2。

1)MobileNet的原理及优势:

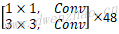

MobileNet把卷积核为k×k的卷积拆分成两步,第1步是按通道维度执行卷积核为k×k的卷积计算,第2步则是将第1步的输出结果用大小为1×1的卷积核进行普通的卷积运算。简单来说,就是大的卷积核按通道方向执行卷积,用小的1×1的卷积核对输出维度做变换。

MobileNet卷积的两个步骤分别称为Depthwise和Pointwise卷积。

· Depthwise卷积:使用大卷积核,3×3的卷积核,每个通道对应一个卷积核执行卷积计算,得到的输出通道数量与输入通道数量一致。

· Pointwise卷积:由于普通卷积得到的通道为2,而Depthwise输出通道为3,二者不一致,通过Pointwise卷积计算,使用1×1的卷积核,按照普通卷积计算算法,将输出通道设置为期望的通道数。

MobileNet使用Depthwise+Pointwise的优势在于,对于大卷积核计算卷积部分,通道维度没有发生变化,使得计算量和参数数量大大压缩;而对于通道变换部分,使用小卷积核计算,将计算量和参数数量压缩。

设输入shape=(Hin,Win,Cin),卷积核高宽(Hf,Wf),输出shape=(Hout,Wout,Cout)。普通卷积,参数量Cin

实际项目中,通道数量往往是好几百,中间层的Feature Map宽高也远大于3,使用MobileNet卷积方式可以大大提升运算速度,减少计算量和参数数量。虽然计算量大幅减少,采用Depthwise+Pointwise卷积可以近似等于普通卷积,在实际训练中精度几乎不会有明显降低。

2)TensorFlow中实现MobileNet:

TensorFlow中,函数tf.nn.depthwise_conv2d用于实现Depthwise卷积计算,函数原型:

tf.nn.depthwise_conv2d(

input,

filter,

strides,

padding,

rate=None,

name=None,

data_format=None

)各个参数的含义及数据类型:

· input:4维Tensor对象,数据格式可以是NHWC或NCHW,由参数data_format决定。

· filter:4维Tensor对象,shape=[filter_height,filter_width,in_channels,channel_multiplier],其中,filter

· strides:是一个长度为4的一维列表,分别表示data_format指定的数据格式中每个维度的stride值。

· padding:字符串对象,可以取SAME或VALID。

· rate:长度为2的一维列表,分别表示空洞卷积在高维度和宽维度数据采样间隔比例。如果该值大于1,那么strides参数的所有值必须等于1。

· name:字符串类型,表示当前Operation的名称。

· data_format:字符串类型,只能取NHWC或NCHW,默认NHWC。

函数tf.nn.depthwise_conv2d输出维度为4的Tensor对象,将Depthwise卷积和Pointwise卷积合在一起的示例:

import tensorflow as tf

import numpy as np

#输入shape=[N,C,H,W]

input=[[

[[2,3,-1,3],[1,4,1,-1],[2,0,4,-3],[4,2,1,2]],

[[3,2,0,1],[1,-4,1,0],[-1,2,3,1],[2,3,5,-2]],

[[-1,2,3,5],[3,-2,-1,2],[4,-5,2,0],[5,1,0,1]]

]]

#shape=[in_channels,filter_height,filter_width]

depthwise_filters=[

[[1,-1,2],[1,0,1],[2,1,0]],

[[1,2,1],[0,2,0],[3,1,1]],

[[1,1,0],[2,0,1],[1,3,2]]

]

#shape=[out_channels,in_channels,filter_height,filter_width]

pointwise_filter=[

[[[-1]],[[1]],[[2]]],

[[[2]],[[1]],[[3]]]

]

def DepthSepConv(input_tf,stride,kernel_size,out_channels,layer_name,relu=tf.nn.relu6

with tf.variable_scope(layer_name+'_depthwise'):

in_size=input_tf.get_shape().as_list()

strides=[1,stride,stride,1]

#dw_kernel_shape=[filter_height,filter_width,in_channels,channels_multiplier]

dw_kernel_shape=[kernel_size,kernel_size,in_size[3],1]

dw_kernel=tf.get_variable('depthwise_weights',dw_kernel_shape,tf.float32

x=tf.nn.depthwise_conv2d(input_tf,dw_kernel,strides,padding='SAME',name=layer_name+'_depthwise')

if batchNorm:

x=tf.contrib.layers.batch_norm(x,center=True,decay=0.9997

if not relu is None:

x=relu(x)

with tf.variable_scope(layer_name+'_pointwise'):

#pointwise conv

pw_kernel_shape=[1,1,in_size[3],out_channels]

pw_kernel=tf.get_variable('weights',pw_kernel_shape,tf.float32,pointwise

x=tf.nn.conv2d(x,pw_kernel,[1,1,1,1],padding='SAME')

if batchNorm:

x=tf.contrib.layers.batch_norm(x,center=True,decay=0.9997,scale=True

if not relu is None:

x=relu(x)

return x

def main():

input_tf=tf.Variable(input,dtype=tf.float32)

#[N,C,H,W]--->[N,H,W,C]

input_tf=tf.transpose(input_tf,(0,2,3,1))

#[in_channels,filter_height,filter_width]

#转为[filter_height,filter_width,in_channels]

depthwise_weights=np.transpose(np.array(depthwise_filters),(1,2,0))

#[filter_height,filter_width,in_channels]

#转为[filter_height,filter_width,in_channels,channel_multiplier]

depthwise_weights=np.expand_dims(depthwise_weights,axis=3)

depthwise_initializer=tf.constant_initialzer(depthwise_weights)

pointwise_weights=np.array(pointwise_filters)

#[out_channels,in_channels,filter_height,filter_width]

#转为[filter_height,filter_width,in_channels,out_channels]

pointwise_weights=np.transpose(pointwise_weights,(2,3,1,0))

pointwise_initializer=tf.constant_initialzer(pointwise_weights)

output_tf=DepthSepConv(input_tf,stride=1,kernel_size=3

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

output=sess.run(output_tf)

#NHWC--->NCHW

output=np.transpose(output,(0,3,1,2))

print(output)

if __name__=='__main__':

main()3)使用Python实现的Depthwise卷积:

import tensorflow as tf

import numpy as np

#输入shape=[C,H,W]

input=[

[[2,3,-1,3],[1,4,1,-1],[2,0,4,-3],[4,2,1,2]],

[[3,2,0,1],[1,-4,1,0],[-1,2,3,1],[2,3,5,-2]],

[[-1,2,3,5],[3,-2,-1,2],[4,-5,2,0],[5,1,0,1]]

]

#shape=[in_channels,filter_height,filter_width]

depthwise_filters=[

[[1,-1,2],[1,0,1],[2,1,0]],

[[1,2,1],[0,2,0],[3,1,1]],

[[1,1,0],[2,0,1],[1,3,2]]

]

#shape=[out_channels,in_channels,filter_height,filter_width]

pointwise_filter=[

[[[-1]],[[1]],[[2]]],

[[[2]],[[1]],[[3]]]

]

def compute_conv(fm,kernel):

'''

#对单个通道计算卷积核大小为3×3的卷积

#这里Padding=SAME,stride=1,卷积核大小3×3

fm: Shape=[in_h,int_w],某个通道

kernel: Shape=[3,3], fm对应的卷积核

return rs: Shape=[out_h,out_w]

'''

fm=np.array(fm)

kernel=np.array(kernel)

[h,w]=fm.shapw

[k,_]=kernel.shape

assert k==3,"Just Support kernel with Shape=[3,3]!"

#定义边界填充0后的map

padding_fm=np.zeros([h+2,w+2],np.float32)

#保存计算结果

rs=np.zeros([h,w],np.float32)

# 将输入在指定该区域赋值,即除了4个边界后,剩下的区域

padding_fm[1:h_1,w+1]=fm

# 对每个点为中心的区域遍历

for i in range(1,h+1):

for j in range(1,w+1):

#取出当前点为中心的k*k区域

roi=padding_fm[i-1:i+2,j-1:j+2]

#计算当前点的卷积,对k*k个点相乘后求和

rs[i-1][j-1]=np.sum(roi*kernel)

return rs

def MyDepthSepConv(CHW_input,depthwise_kernel,pointwise_kernel):

#Depthwise

depthwise_output=[]

for hw,depth_weights in zip(CHW_input,depthwise_kernel):

rs=compute_conv(hw,depth_weights)

depthwise_output.append(rs)

depthwise_output=np.array(depthwise_output)

c,h,w=depthwise_output.shape

output=[]

#Pointwise

for points_kernels in pointwise_kernel:

rs=np.zeros((h,w),dtype=np.float32)

#points_kernels shape=[in_channels,f_height,f_width]

for filter,fm in zip(points_kernels,depthwise_output);

rs=rs+filter[0][0]*fm

output.append(rs)

return np.array(output)

def main():

output=MyDepthSepConv(input,depthwise_filters,pointwise_filters)

print(output)

if __name__=='__main__':

main()上述代码只适用于卷积核3×3、Padding=SAME、stride=1的单通道输入和单通道输出卷积计算,可以扩充到任意自定义参数。

4)MobileNet完整的网络结构:

MobileNet对每一层卷积(包括Depthwise和Pointwise)添加了Batch Normalization和ReLU6计算,且卷积后面没有加bias项。基础网络结构见下表:

| 网络层 | Stride | 卷积核shape [height,width,in_c,out_c] |

输入shape [height,width,channel] |

输出shape [height,width,channel] |

|

|---|---|---|---|---|---|

| Conv | 2 | [3,3,3,32] | [224,224,3] | [112,112,32] | |

| Depthwise | 1 | [3,3,32,32] | [112,112,32] | [112,112,32] | |

| Pointwise | 1 | [1,1,32,64] | [112,112,32] | [112,112,64] | |

| Depthwise | 2 | [3,3,64,64] | [112,112,64] | [56,56,64] | |

| Pointwise | 1 | [1,1,64,128] | [56,56,64] | [56,56,128] | |

| Depthwise | 1 | [3,3,128,128] | [56,56,128] | [56,56,128] | |

| Pointwise | 1 | [1,1,128,128] | [56,56,128] | [56,56,128] | |

| Depthwise | 2 | [3,3,128,128] | [56,56,128] | [28,28,128] | |

| Pointwise | 1 | [1,1,128,256] | [28,28,128] | [28,28,256] | |

| Depthwise | 1 | [3,3,256,256] | [28,28,256] | [28,28,256] | |

| Pointwise | 1 | [1,1,256,256] | [28,28,256] | [28,28,256] | |

| Depthwise | 2 | [3,3,256,256] | [28,28,256] | [14,14,256] | |

| Pointwise | 1 | [1,1,256,512] | [14,14,256] | [14,14,512] | |

| 5x | Depthwise | 1 | [3,3,512,512] | [14,14,512] | [14,14,512] |

| Pointwise | 1 | [1,1,512,512] | [14,14,512] | [14,14,512] | |

| Depthwise | 2 | [3,3,512,512] | [14,14,512] | [7,7,512] | |

| Pointwise | 1 | [1,1,512,1024] | [7,7,512] | [7,7,1024] | |

| Depthwise | 1 | [3,3,1024,1024] | [7,7,1024] | [7,7,1024] | |

| Pointwise | 1 | [1,1,1024,1024] | [7,7,1024] | [7,7,1024] | |

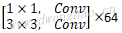

为了进一步提升模型执行速度及裁剪网络参数,Google在2018年发布MobileNet V2,使用了更少的参数和更少的计算量,却有更高的精度。

MobileNet V2引入shortcut,并采用Pointwise+Depthwise+Pointwise结构取代标准卷积计算。

MobileNet V2多了一层Pointwise,看上去会有更多参数和计算量,但第1层Pointwise会将通道数放大N倍(官方采用6倍),但MobileNet V2的Block输入和输出通道数远比MobileNet V1小,大部分V1的Cin远大于V2的Cin。MobileNet V2的完整网络结构见下表:

| Input | Operator | t | Channels | n | s |

|---|---|---|---|---|---|

| 224×224×3 | Conv2d | - | 32 | 1 | 2 |

| 112×112×32 | Bottleneck | 1 | 16 | 1 | 1 |

| 112×112×16 | Bottleneck | 6 | 24 | 2 | 2 |

| 56×56×24 | Bottleneck | 6 | 32 | 3 | 2 |

| 28×28×32 | Bottleneck | 6 | 64 | 4 | 2 |

| 28×28×64 | Bottleneck | 6 | 96 | 5 | 1 |

| 14×14×96 | Bottleneck | 6 | 160 | 5 | 2 |

| 7×7×160 | Bottleneck | 6 | 320 | 1 | 1 |

| 7×7×320 | Conv2d 1×1 | - | 1280 | 1 | 1 |

| 7×7×1280 | Avgpool 7×7 | - | - | 1 | - |

| 1×1×k | Bottleneck | - | k | - | - |

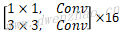

2. 深度残差网络ResNet:

深度残差网络Deep Residual Network于2015年被提出,在当年的ImageNet分类比赛中获得第一名。ResNet简单、实用。

1)ResNet的结构与优势:

理论上,随着网络深度加深,参数量变多,网络模型的精度会变高。实际上,随着网络的加深,当深度达到一定程度时,在训练集中准确率反而会变差,这主要是因为梯度消失的问题。随着网络的加深,梯度反向传播到前面层,连续的梯度乘法很容易使得梯度无穷小。

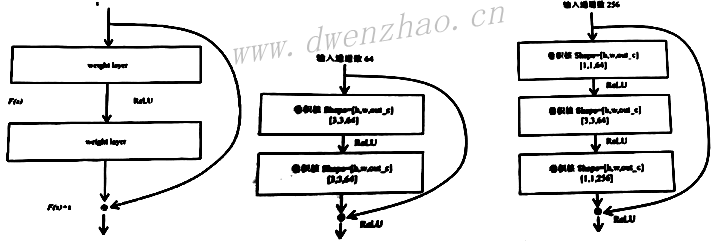

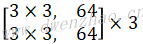

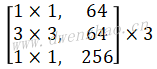

梯度消失带来的后果就是,网络的性能随着深度的加深趋于饱和,甚至退化,使得深层次网络很难训练。ResNet由多个卷积Block组成,其卷积Block如左图:

注意,在使用shortcut对Block的输入和输出做加法时,如果通道维度不一样,shortcut会增加一个1×1卷积对Block输入做卷积运算,使得加法计算的两个输入通道维度一致。

2)TensorFlow中实现ResNet:

TensorFlow官方实现了ResNet,中图Block的源码为:

#创建Block

def _building_block_v1(inputs,filters,training,projection_shortcut,strides,data_format):

#保留输入的引用

shortcut=inputs

#如果输入通道数与输出通道数不一致,则通过传入projection_shortcut变换,即1×1卷积

if projection_shortcut is not None:

#projection_shortcut函数是1×1卷积计算

shortcut=projection_shortcut(inputs)

shortcut=batch_norm(inputs=shortcut,training=training

#执行3×3卷积运算,输出指定通道数为filters